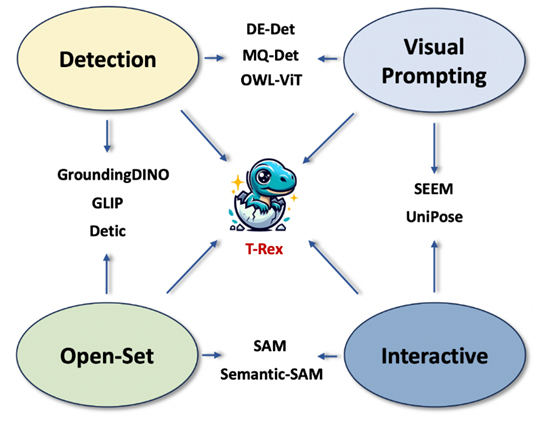

继火爆出圈的 Grounded SAM 之后,IDEA 研究院团队携重磅新作归来:视觉提示(Visual Prompt)模型 T-Rex,以图识图,开箱即用,开启开集检测新天地!

“拉框、检测、完成!”

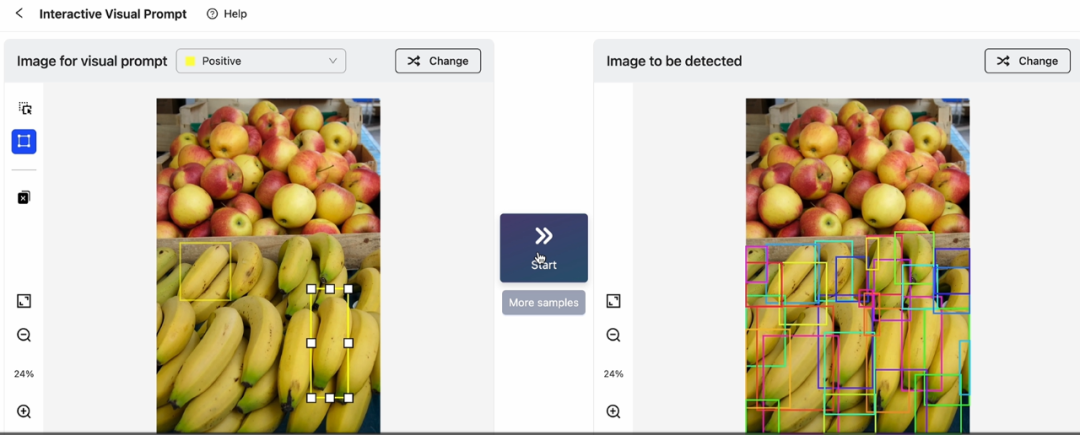

在刚刚结束的 2023 IDEA 大会上,IDEA 研究院创院理事长、美国国家工程院外籍院士沈向洋展示了基于视觉提示的目标检测新体验,并发布了全新视觉提示模型 T-Rex 的模型实验室(playground), Interactive Visual Prompt(iVP),掀起现场一波试玩小高潮。(点击前往亲自试玩)

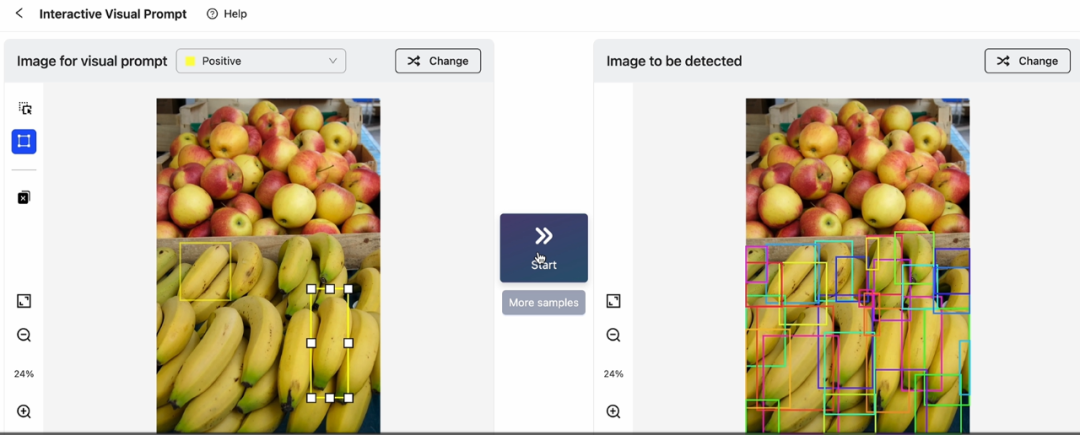

在 iVP 上,用户可以亲自解锁“一图胜千言”的 Prompting:在图片上标记感兴趣的对象,向模型提供视觉示例,模型随即检测出目标图片中与之相似的所有实例。整套流程交互便捷,只需几步操作就可轻松完成。

操作演示

IDEA 研究院 4 月份发布的 Grounded SAM (Grounding DINO + SAM) 曾在 Github 上火爆出圈,至今已狂揽 11K 星。有别于只支持文字提示的 Grounded SAM,此次发布的 T-Rex 模型提供着重打造强交互的视觉提示功能。

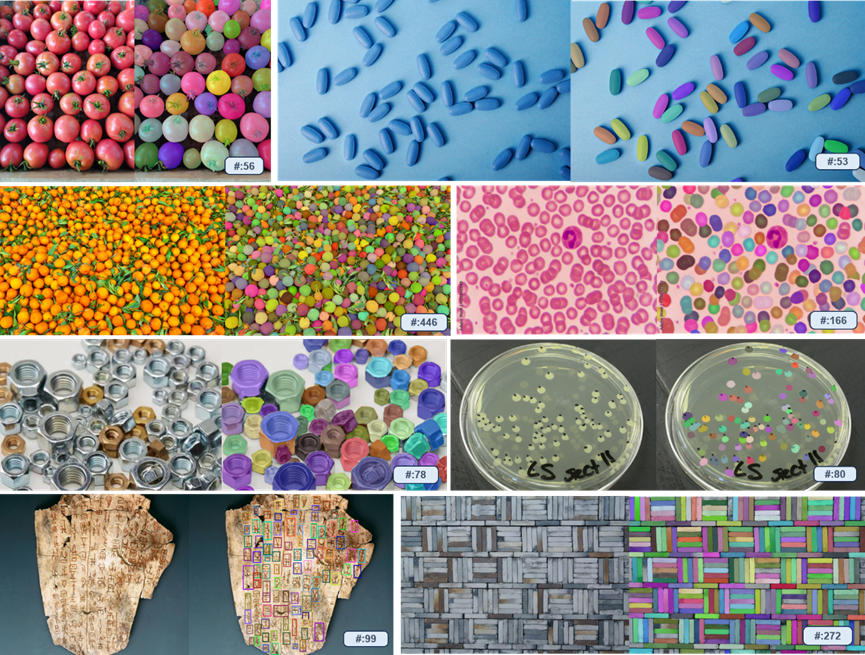

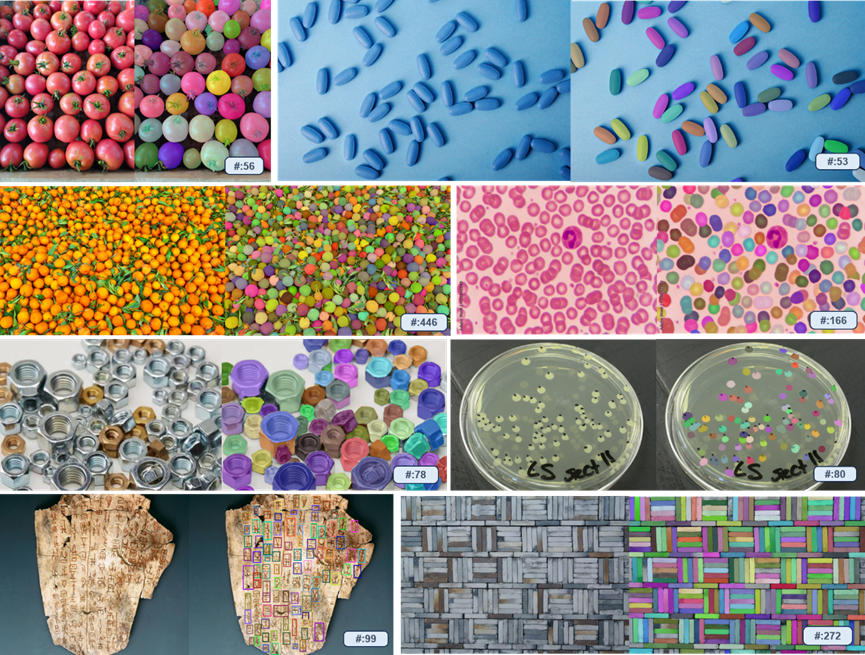

T-Rex 具备极强的开箱即用特性,无需重新训练或微调,即可检测模型在训练阶段从未见过的物体。该模型不仅可应用于包括计数在内的所有检测类任务,还为智能交互标注领域提供新的解决方案。

团队透露,研发视觉提示技术是源自对真实场景中痛点的观察。有合作方希望利用视觉模型对卡车上的货物数量进行统计。然而,仅通过文字提示,模型无法单独识别出每一个货物。其原因是工业场景中的物体在日常生活中较为罕见,难以用语言描述。在此情况下,视觉提示显然是更高效的方法。与此同时,直观的视觉反馈与强交互性,也有助于提升检测的效率与精准度。

基于对实际使用需求的洞察,团队将 T-Rex 设计成可以接受多个视觉提示的模型,且具备跨图提示能力。除了最基本的单轮提示模式,目前还支持以下三种进阶模式。

· 多轮正例模式:适用于视觉提示不够精准造成漏检的场景

· 正例+负例模式: 适用于视觉提示带有二义性造成误检的场景

· 跨图模式:适用于通过单张参考图提示检测他图的场景

在同期发布的技术报告中,团队总结了 T-Rex 模型的四大特性:

开放集:不受预定义类别限制,具有检测一切物体的能力

视觉提示:利用视觉示例指定检测目标,克服罕见、复杂物体难以用文字充分表达的问题,提高提示效率

直观的视觉反馈:提供边界框等直观视觉反馈,帮助用户高效评估检测结果

交互性:用户可通过便捷交互,积极参与检测过程,对模型结果进行纠错

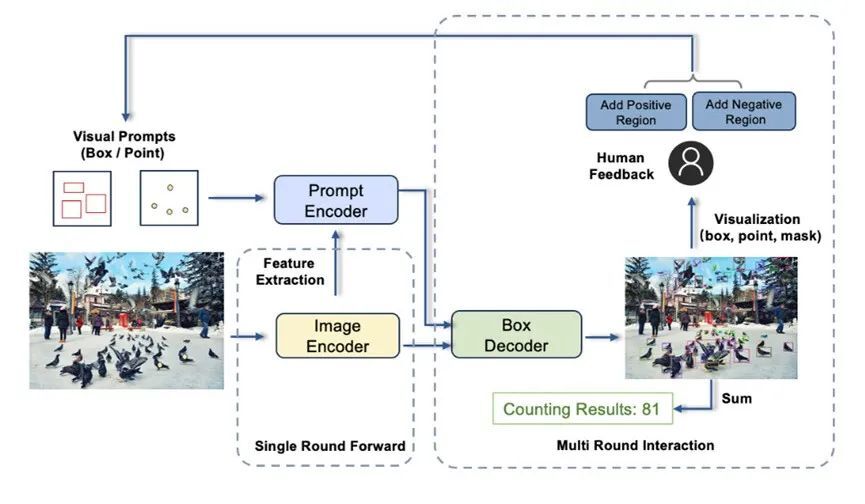

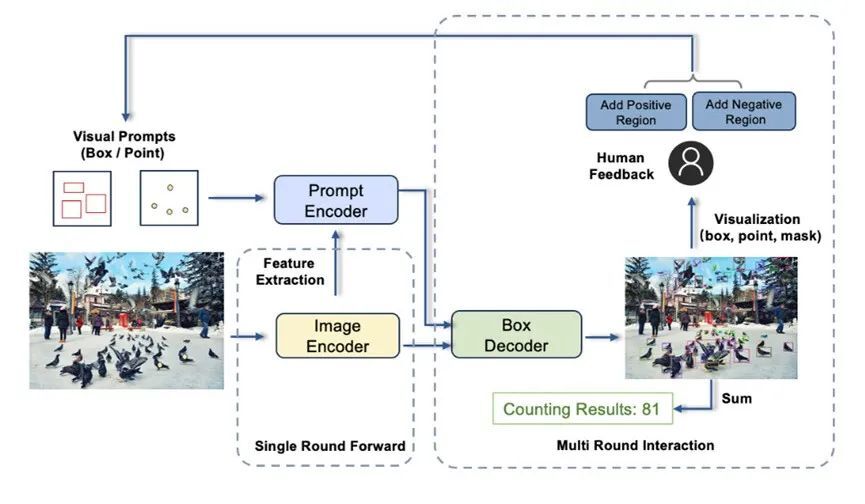

T-REX 模型由图像编码器、提示编码器、框解码器组成

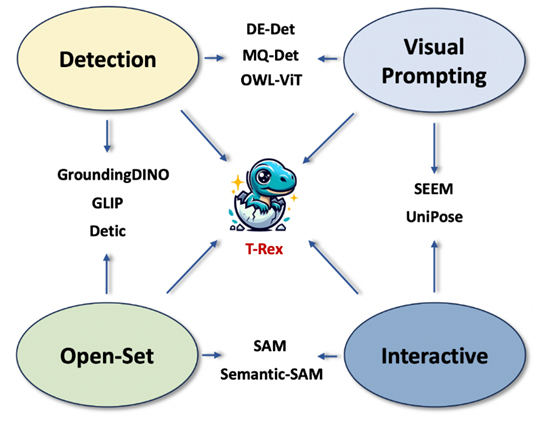

研究团队指出,在目标检测场景中,视觉提示的加入能够补足文本提示的部分缺陷。未来,两者的结合将进一步释放 CV 技术在更多垂直领域的落地潜能。

iVP 模型实验室:点击

报告链接: 点击

Github 链接:点击

本项工作来自 IDEA 研究院计算机视觉与机器人研究中心(CVR)。该团队此前开源的目标检测模型 DINO 是首个在 COCO 目标检测上取得榜单第一的 DETR 类模型。在 Github 上大火的零样本检测器 Grounding DINO 与能够检测、分割一切的 Grounded SAM,同样为该团队作品。

彩蛋

T-Rex,来自于“Tyrannosaurus Rex”的缩写,中文名为霸王龙,也是 CVR 团队 DINO 恐龙系列工作的延伸。一个关于霸王龙的冷知识:经过科学家的研究,霸王龙是各种恐龙中视力最好的,是人的视力的 13 倍,甚至比鹰的视力还好(鹰的视力只是人的 3.6 倍)。

T-Rex 模型的 Logo 是一只刚破壳而出的可爱小霸王龙,寓意着 T-Rex 模型刚刚诞生,但有着巨大的发展潜力,有朝一日将进化得更加强大。

继火爆出圈的 Grounded SAM 之后,IDEA 研究院团队携重磅新作归来:视觉提示(Visual Prompt)模型 T-Rex,以图识图,开箱即用,开启开集检测新天地!

“拉框、检测、完成!”

在刚刚结束的 2023 IDEA 大会上,IDEA 研究院创院理事长、美国国家工程院外籍院士沈向洋展示了基于视觉提示的目标检测新体验,并发布了全新视觉提示模型 T-Rex 的模型实验室(playground), Interactive Visual Prompt(iVP),掀起现场一波试玩小高潮。(点击前往亲自试玩)

在 iVP 上,用户可以亲自解锁“一图胜千言”的 Prompting:在图片上标记感兴趣的对象,向模型提供视觉示例,模型随即检测出目标图片中与之相似的所有实例。整套流程交互便捷,只需几步操作就可轻松完成。

操作演示

IDEA 研究院 4 月份发布的 Grounded SAM (Grounding DINO + SAM) 曾在 Github 上火爆出圈,至今已狂揽 11K 星。有别于只支持文字提示的 Grounded SAM,此次发布的 T-Rex 模型提供着重打造强交互的视觉提示功能。

T-Rex 具备极强的开箱即用特性,无需重新训练或微调,即可检测模型在训练阶段从未见过的物体。该模型不仅可应用于包括计数在内的所有检测类任务,还为智能交互标注领域提供新的解决方案。

团队透露,研发视觉提示技术是源自对真实场景中痛点的观察。有合作方希望利用视觉模型对卡车上的货物数量进行统计。然而,仅通过文字提示,模型无法单独识别出每一个货物。其原因是工业场景中的物体在日常生活中较为罕见,难以用语言描述。在此情况下,视觉提示显然是更高效的方法。与此同时,直观的视觉反馈与强交互性,也有助于提升检测的效率与精准度。

基于对实际使用需求的洞察,团队将 T-Rex 设计成可以接受多个视觉提示的模型,且具备跨图提示能力。除了最基本的单轮提示模式,目前还支持以下三种进阶模式。

· 多轮正例模式:适用于视觉提示不够精准造成漏检的场景

· 正例+负例模式: 适用于视觉提示带有二义性造成误检的场景

· 跨图模式:适用于通过单张参考图提示检测他图的场景

在同期发布的技术报告中,团队总结了 T-Rex 模型的四大特性:

开放集:不受预定义类别限制,具有检测一切物体的能力

视觉提示:利用视觉示例指定检测目标,克服罕见、复杂物体难以用文字充分表达的问题,提高提示效率

直观的视觉反馈:提供边界框等直观视觉反馈,帮助用户高效评估检测结果

交互性:用户可通过便捷交互,积极参与检测过程,对模型结果进行纠错

T-REX 模型由图像编码器、提示编码器、框解码器组成

研究团队指出,在目标检测场景中,视觉提示的加入能够补足文本提示的部分缺陷。未来,两者的结合将进一步释放 CV 技术在更多垂直领域的落地潜能。

iVP 模型实验室:点击

报告链接: 点击

Github 链接:点击

本项工作来自 IDEA 研究院计算机视觉与机器人研究中心(CVR)。该团队此前开源的目标检测模型 DINO 是首个在 COCO 目标检测上取得榜单第一的 DETR 类模型。在 Github 上大火的零样本检测器 Grounding DINO 与能够检测、分割一切的 Grounded SAM,同样为该团队作品。

彩蛋

T-Rex,来自于“Tyrannosaurus Rex”的缩写,中文名为霸王龙,也是 CVR 团队 DINO 恐龙系列工作的延伸。一个关于霸王龙的冷知识:经过科学家的研究,霸王龙是各种恐龙中视力最好的,是人的视力的 13 倍,甚至比鹰的视力还好(鹰的视力只是人的 3.6 倍)。

T-Rex 模型的 Logo 是一只刚破壳而出的可爱小霸王龙,寓意着 T-Rex 模型刚刚诞生,但有着巨大的发展潜力,有朝一日将进化得更加强大。