近日,ICCV 2023 正式公布论文收录结果,IDEA 研究院 12 篇论文入选,在开放词表目标检测与分割、交互式关键点标注、可控文生图、3D 目标检测、3D 重建、肖像视频生成等领域取得新成果。

ICCV(国际计算机视觉大会,International Conference on Computer Vision)是计算机视觉领域的顶级会议之一,每两年召开一次。根据 Google Scholar Metrics 2022 年榜单,ICCV 在所有计算机科学领域的刊物和会议中位居第 4。ICCV 2023 将于 10 月 2 日至 10 月 6 日法国巴黎举办。

跟随本期文章了解 IDEA 研究院 CV 领域的部分学术成果,欢迎感兴趣的读者阅读论文原文。

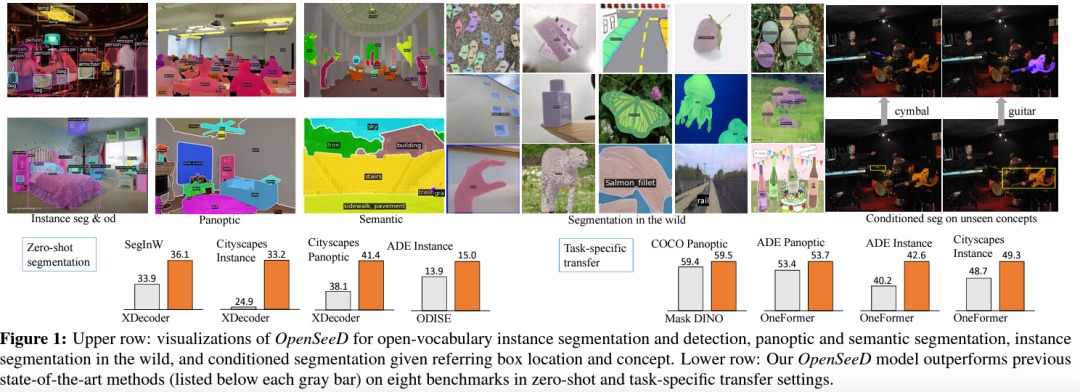

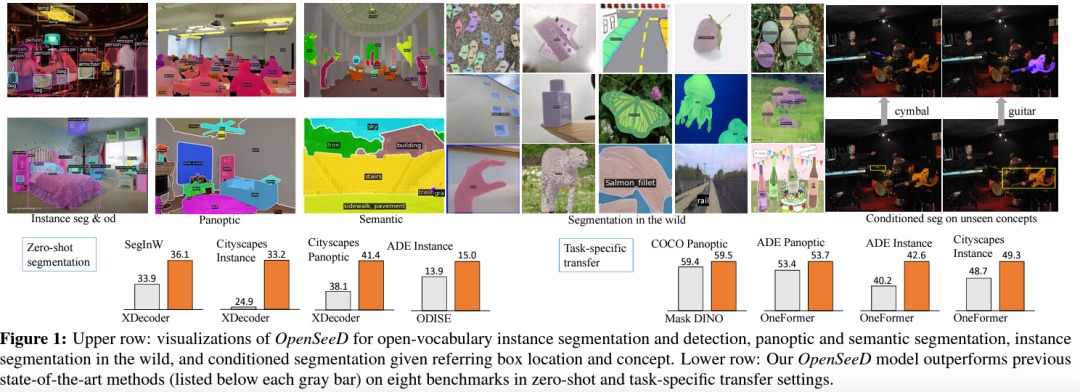

简单有效的开放词表分割框架,未见之物亦可分割,是已知的第一个同时训练全景分割和目标检测提升开集分割性能的模型。

摘要:本文提出了一个开放词表图像分割和检测的框架,解决了检测和分割同时训练过程中的 data gap 和 training gap,实现了两大任务在开放词表内的联合训练,并大大提升了分割性能。本文在 COCO 全景分割榜单取得 SOTA,并在多个开集分割任务上超越主流方法。

论文链接:

https://arxiv.org/pdf/2303.08131.pdf

代码链接:

https://github.com/IDEA-Research/OpenSeeD

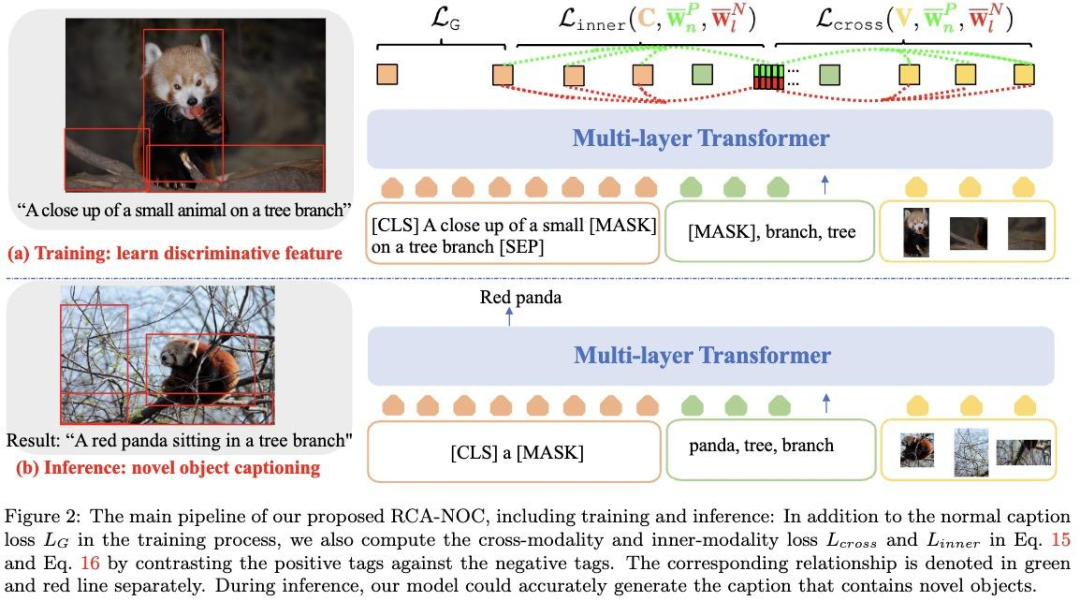

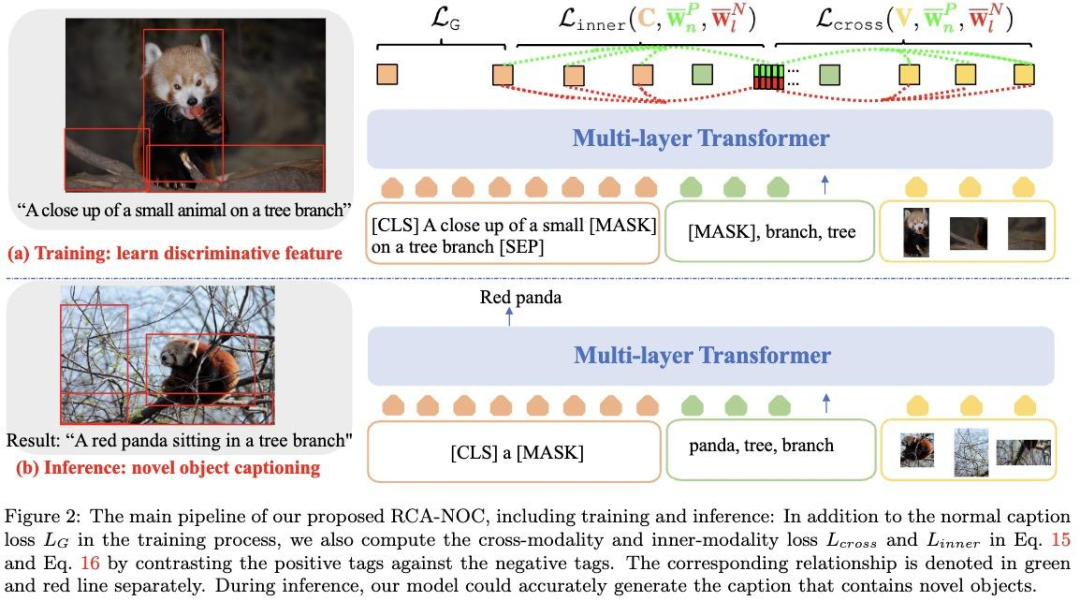

一个改进新物体标题生成任务多模态表示能力的全新方法。

摘要:本文提出了一种新型的新物体图像标题生成方法,该方法采用相对对比学习来学习视觉和语义对齐,以最大化区域与物体标签的兼容性。为了设置合适的对比学习目标,对于每一张图片,我们使用 CLIP 来扩增标签,并利用每个扩增标签的排序位置作为相对的相关性标签,将每个排名最高的标签与一组排名较低的标签进行对比。这个学习目标鼓励排名最高的标签与其图片和文本上下文的兼容性超过排名较低的标签,从而提高了学习的多模态表示的辨别能力。我们在两个数据集上评估了我们的方法,RCA-NOC 大幅度超越了目前最好的方法,展示出其在改进新物体标题生成任务上的视觉-语言表示的有效性。

(论文链接待公开)

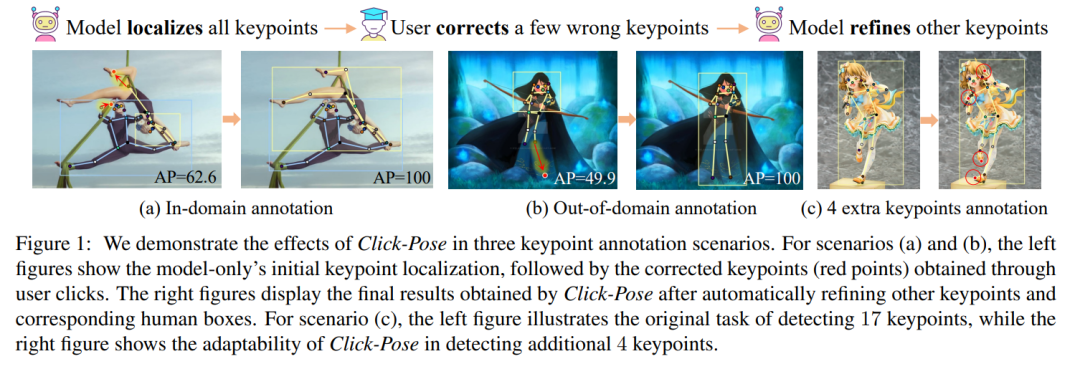

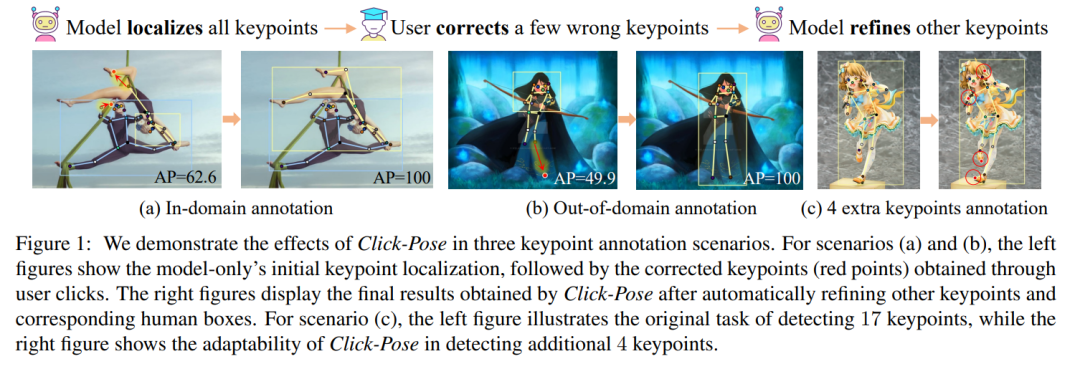

首次定义交互式关键点检测任务,基准框架方法标注效率超越纯手工 10+倍。

摘要:本文首次定义了交互式关键点检测的任务,旨在追求高精度和低成本的标注,并提出了解决该任务的基准框架 Click-Pose,在训练中引入姿态误差建模和交互式人类反馈循环。本方案可以稳定提升标注效率和质量,我们在不同的标注场景中广泛验证了 Click-Pose 的交互式标注有效性,相对手工标注效率提升 10 倍以上,相对 SOTA 模型结合人工修改可提升 5 倍左右,且实现了端到端关键点检测的最先进性能。

(论文链接待公开)

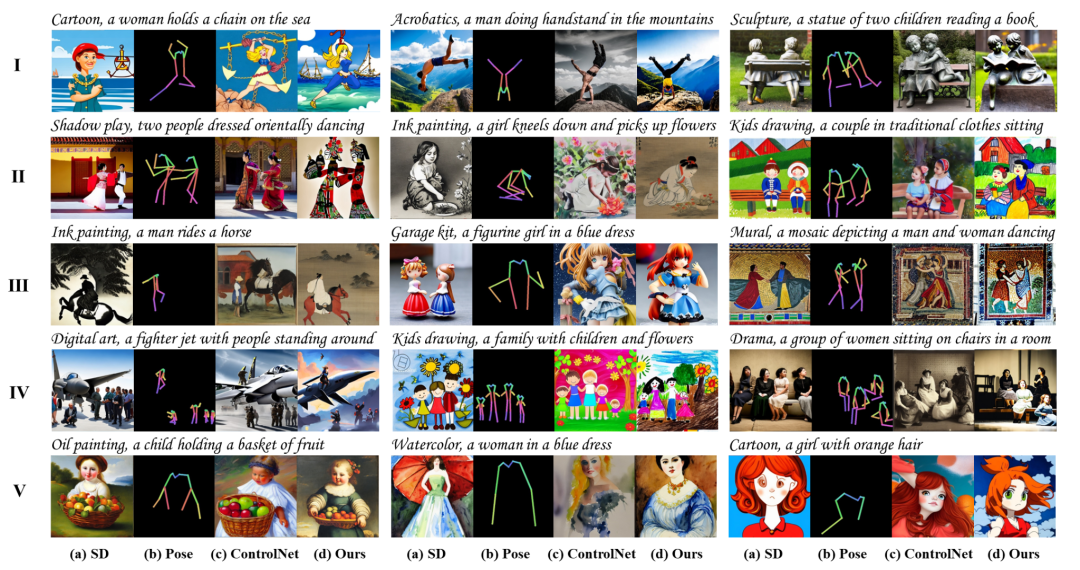

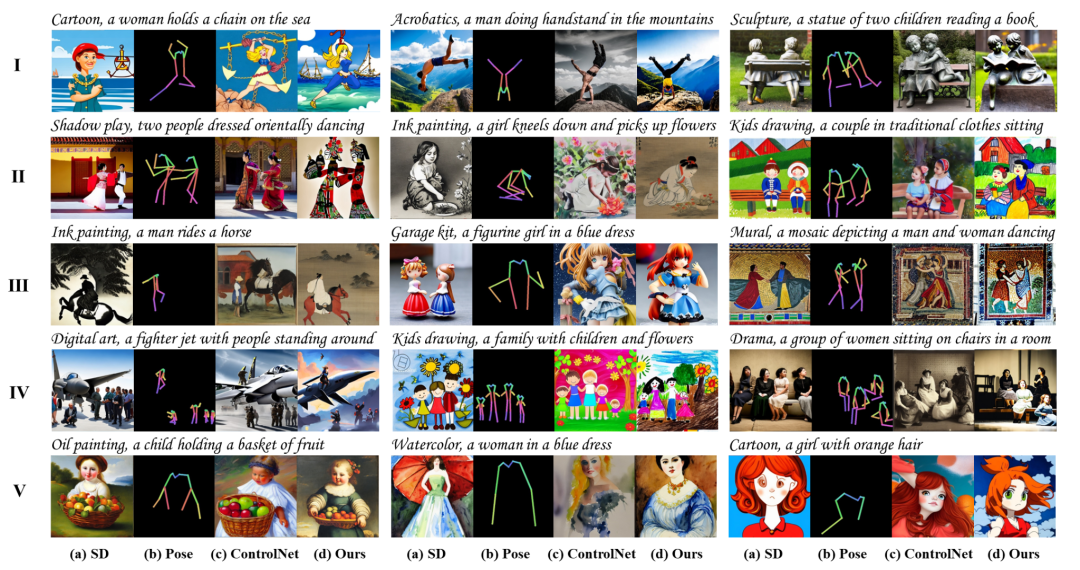

比 ControlNet 更可控更高效的人体图像生成模型 HumanSD。

摘要:本文提出了一个可控人物图像生成方法 HumanSD,旨在高效、准确、原生地控制以人为中心的图片的生成。具体来说,HumanSD 使用一种新颖的热图引导去噪损失(heatmap-guided denoising loss)来微调预训练的 Stable Diffusion 模型,这种策略有效加强了骨骼条件的控制力,同时减轻了灾难性遗忘效应。相比 ControlNet、T2I-Adapter 等即插即用的双分支控制方法,HumanSD 展现了更优的可控力和更快的生成速度,其中可控精度提升 73%。同时,我们提供了适用于人体生成的大规模公开数据集用于后续研究。

论文链接:

https://arxiv.org/abs/2304.04269

代码链接:

https://github.com/IDEA-Research/HumanSD

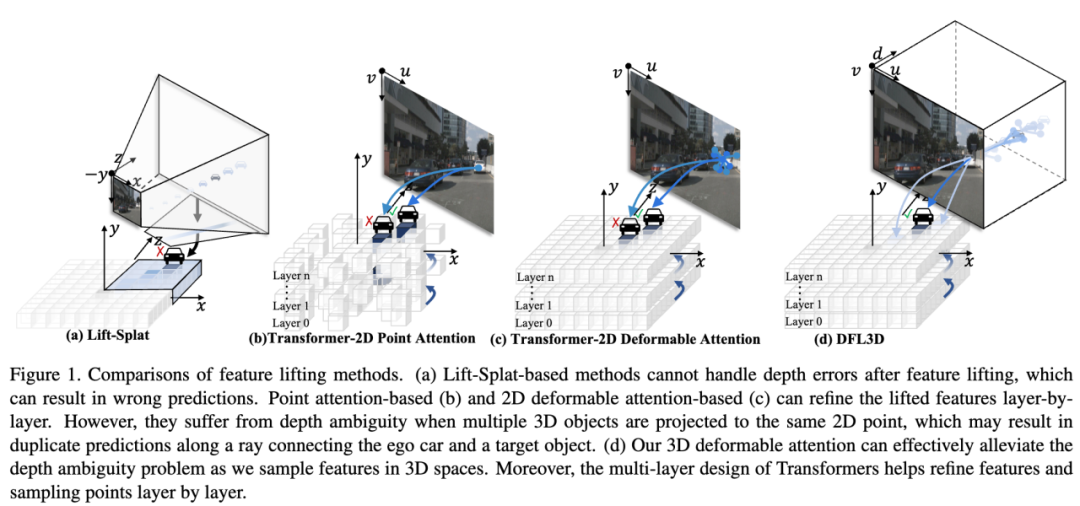

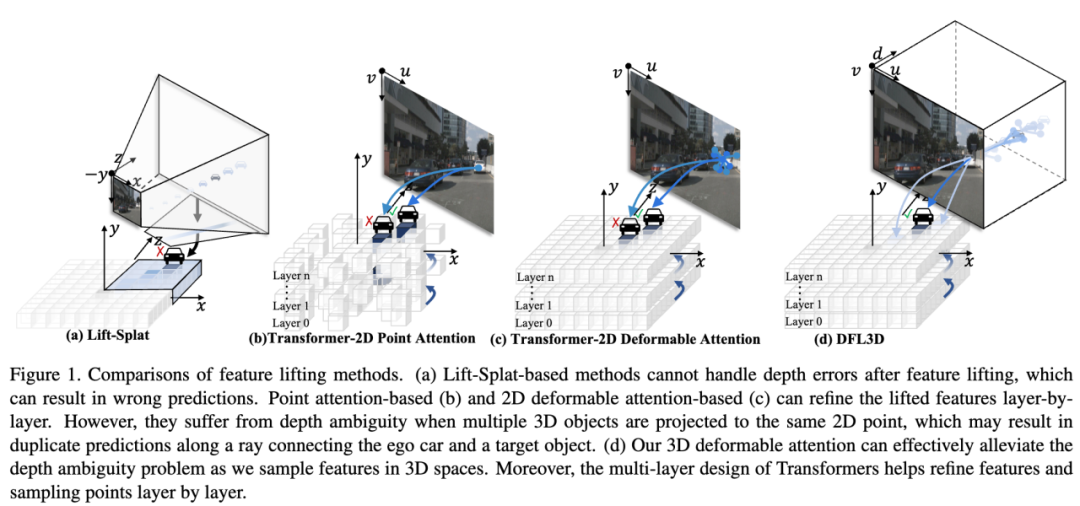

一个全新基础算子以及基于其实现 2D 特征拉升至 3D 空间的新方法。

摘要:本文提出了一个基础算子:3D Deformable Attention(DFA3D)。基于 DFA3D,我们提出了一种全新的将 2D 特征拉升到 3D 空间的方法。我们与其他的特征拉升方法(Lift-Splat-based、2D Deformable Attention-based 等)进行了公平比较,结果验证了我们 DFA3D-based 的方法的优越性。我们在多个多视角 3D 目标检测方法上进行对比实验,进一步验证了我们的方法的有效性和泛化性。

(论文链接待公开)

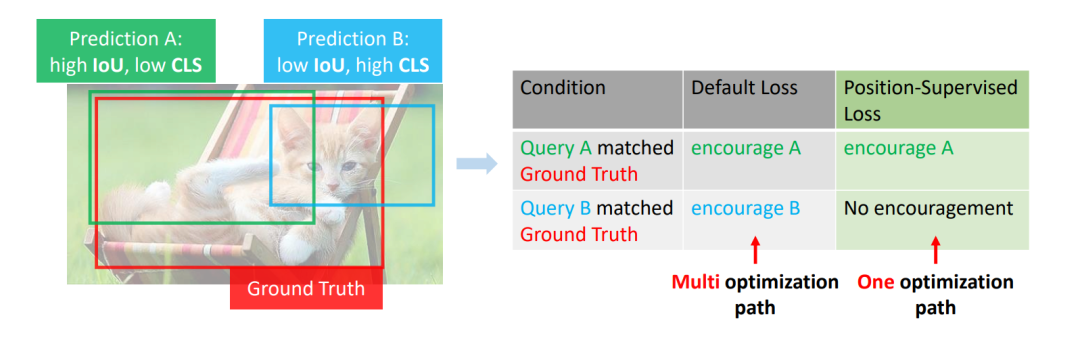

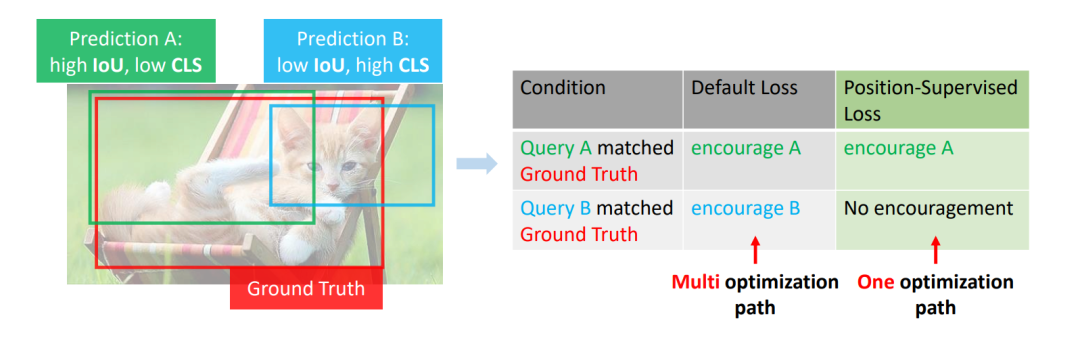

通过在损失中仅引入位置度量来改进 DETR 模型匹配稳定性,大幅提升性能。

摘要:本文指出 DETR 中存在的不稳定匹配问题是由多重优化路径所导致,这一问题在 DETR 的 one-to-one matching 中更加明显。论文表明,仅需要在分类损失中引入了位置度量即可很好地优化问题。基于这一原则,我们通过引入了位置度量信息,提出了两个简单有效并且可适用于所有 DETR 系列模型的 position-supervised loss 和 position-modulated matching cost 设计。

我们基于 DETR 系列模型对方法的有效性进行了验证,其中,Stable-DINO 在以 ResNet-50 作为 backbone 的条件下,在 1x 和 2x 标准 settings 下分别达到了 50.4AP 和 51.5AP。本文方法具有强大的可拓展性,使用 Swin-Large 和 Focal-Huge backbone 的条件下,Stable-DINO 在 COCO test-dev 上分别达到了 63.8AP 和 64.8AP 的准确率。

论文链接:

https://arxiv.org/abs/2304.04742

代码链接:

https://github.com/IDEA-Research/Stable-DINO

一个基于编码器、从单图进行 3D 重建的高效方法。

摘要:3D GAN Inversion 旨在从单个图像输入中同时实现高重建保真度和合理的 3D 几何。然而,现有的 3D GAN Inversion 方法依赖于耗时的优化过程,并且是每张图片单独优化。在这项工作中,我们介绍了一种基于 EG3D 的新型基于编码器的 Inversion 框架,EG3D 是最广泛使用的 3D GAN 模型之一。我们利用 EG3D 隐空间的固有属性,设计了一个鉴别器和背景深度正则化,训练出一个具备几何感知能力的编码器,能够将输入图像转换为相应的隐空间向量。此外,我们探索了 EG3D 的特征空间,并开发了一个自适应细化阶段,以提高 EG3D 中特征的表示能力,从而增强细粒度纹理细节的恢复。最后,我们提出了一种考虑遮挡的融合操作,以防止未观察区域的畸变。我们的方法结果可与基于优化的方法媲美,同时运行速度提高了 500 倍。我们的框架非常适用于语义编辑等应用。

论文链接:

https://arxiv.org/pdf/2303.12326.pdf

代码链接:

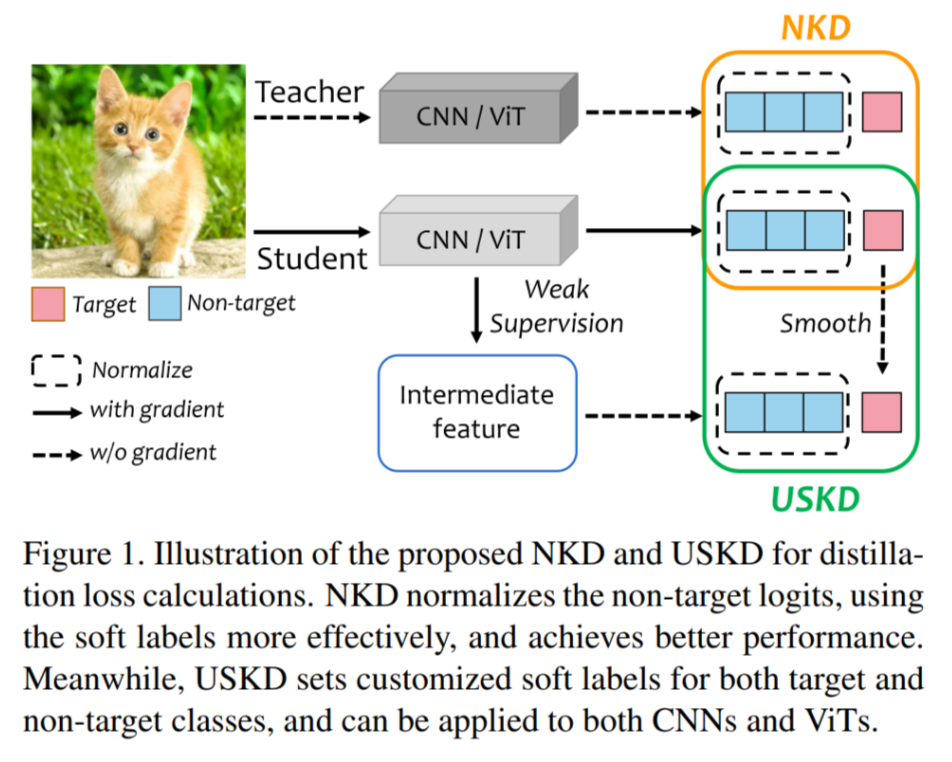

从蒸馏到自蒸馏:通用归一化损失与定制化软标签。

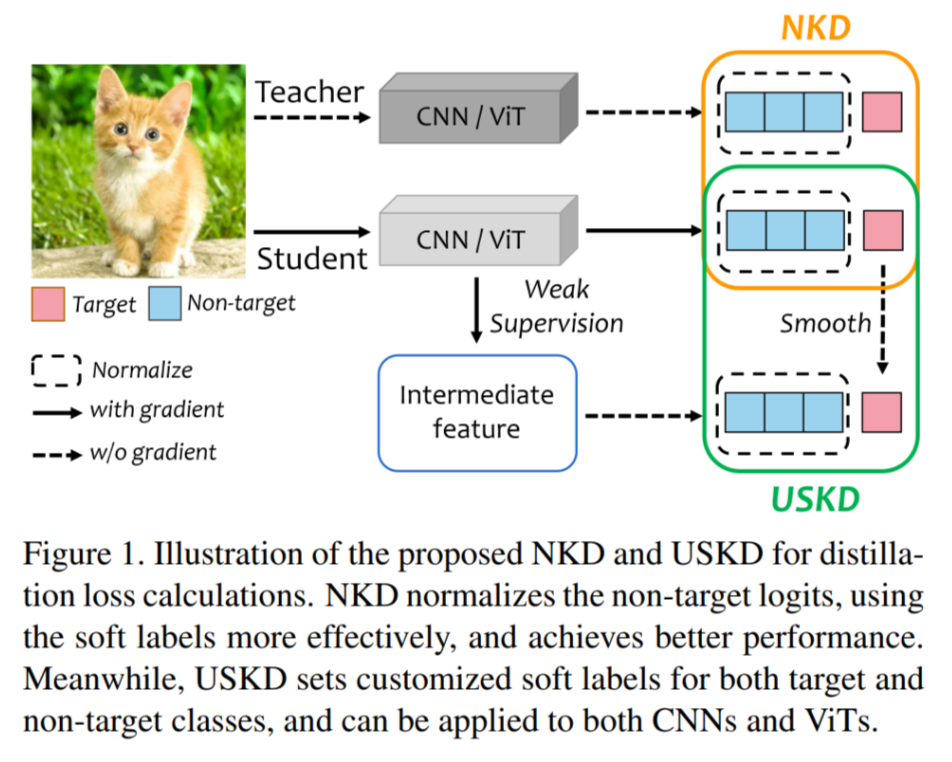

摘要:知识蒸馏(KD)使用教师的预测 logits 作为软标签来指导学生,而自知蒸馏则不需要真实的教师来提供软标签。本研究通过将通用的 KD 损失分解和重新组织,将这两个任务的公式统一为标准化 KD(NKD)损失和针对目标类别(图像的类别)和非目标类别的定制软标签,命名为通用自知蒸馏(USKD)。我们将 KD 损失分解,并发现其中的非目标损失强制使学生的非目标 logits 与教师的相匹配,但两个非目标 logits 的总和不同,防止它们完全相同。NKD 将非目标 logits 进行归一化,使它们的总和相等。它可以广泛应用于 KD 和自知蒸馏,以更好地利用软标签进行蒸馏损失。USKD 为目标和非目标类别生成定制的软标签,而无需教师。它将学生的目标 logit 平滑处理为软目标标签,并利用中间特征的排名按照 Zipf 定律生成软非目标标签。对于带有教师的 KD,我们的 NKD 在 CIFAR-100 和 ImageNet 数据集上实现了最先进的性能,使用 ResNet-34 教师将 ResNet18 的 ImageNet Top-1 准确率从 69.90%提升到 71.96%。对于没有教师的自知蒸馏,USKD 是第一个可以有效应用于 CNN 和 ViT 模型的自知蒸馏方法,额外的时间和内存开销可以忽略不计,从而获得了新的最先进结果,例如在 ImageNet 上,MobileNet 和 DeiT-Tiny 分别获得了 1.17%和 0.55%的准确率提升。 论文链接:

论文链接:

https://arxiv.org/pdf/2303.13005.pdf

代码链接:

https://github.com/yzd-v/cls_KD

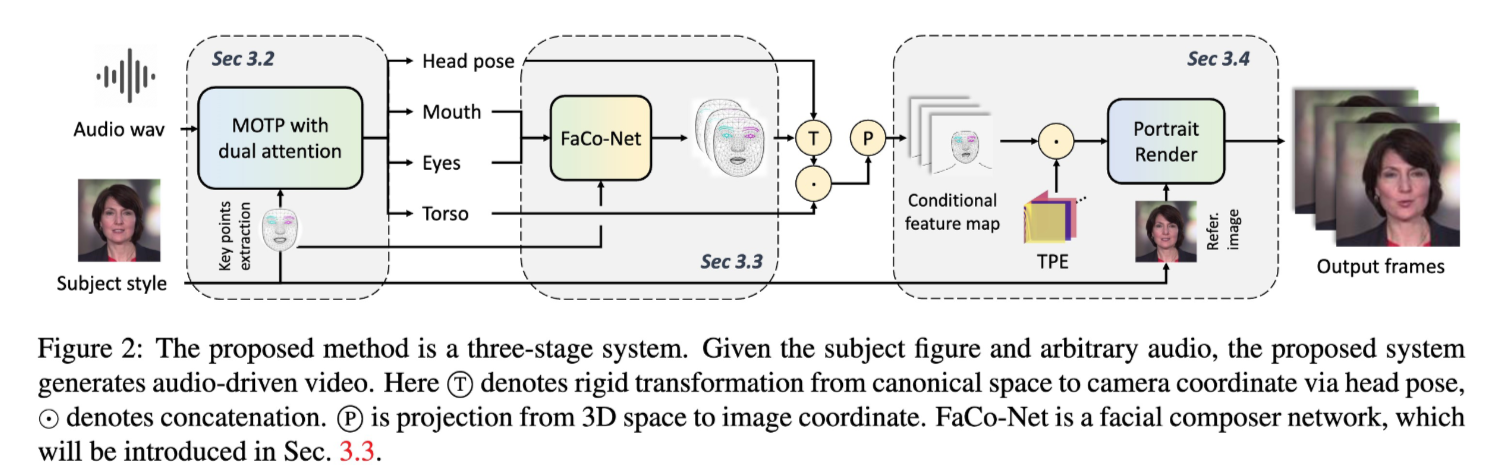

一个从音频驱动指定人物生成高保真且多样的肖像视频的框架。

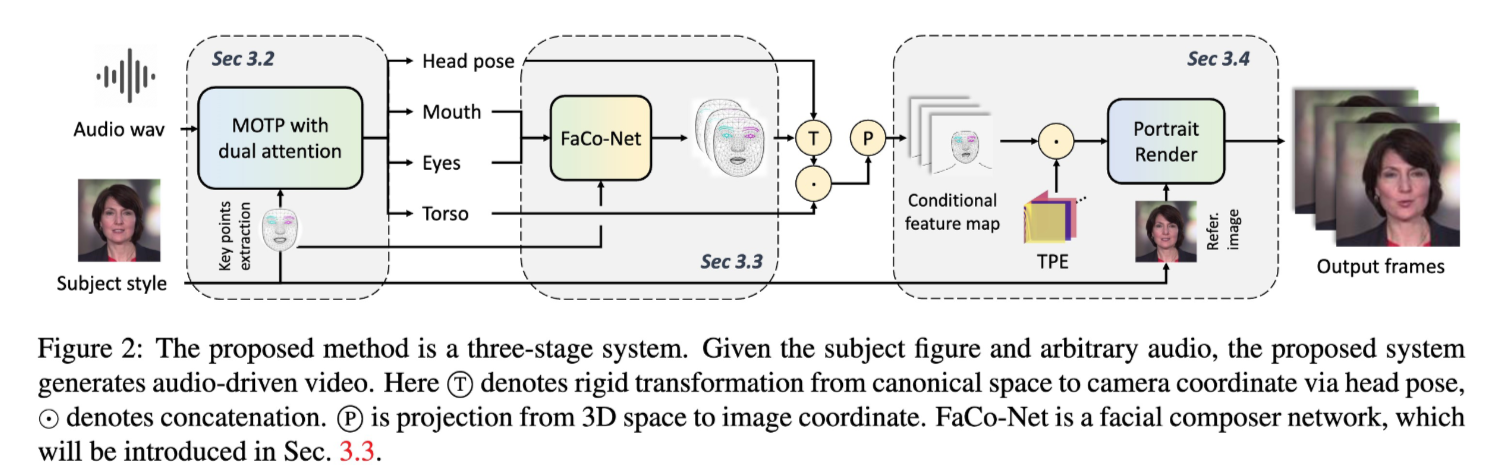

摘要:音频驱动的肖像视频生成旨在通过给定的音频驱动指定肖像的视频。驱动保真度和多模态的肖像视频肖像具有广泛应用。以往的方法尝试通过训练不同模型或从给定视频中提取信号来捕捉不同的运动模式,以此生成高保真度的肖像视频。然而,缺乏音-唇同步与其他动作(例如头部姿势/眼睛眨动)之间的相关度学习通常导致不自然的驱动结果。在本文中,我们提出了一个统一的系统,用于多人、多模态和高保真度的说话肖像视频生成。该方法包含三个阶段:1)带有双重注意力的网络(MODA)从给定音频中生成说话相关的表征。在 MODA 中,我们设计了一个双重注意力模块,以编码准确的口部动作和多样的模态信息。2)面部合成网络生成密集且详细的面部关键点。3)时序引导的渲染器合成稳定的视频。广泛的评估结果表明,所提出的系统比同期其他方法生成的视频肖像更加自然和逼真。

项目链接:

https://liuyunfei.net/projects/iccv23-moda

代码链接:

https://github.com/DreamtaleCore/MODA

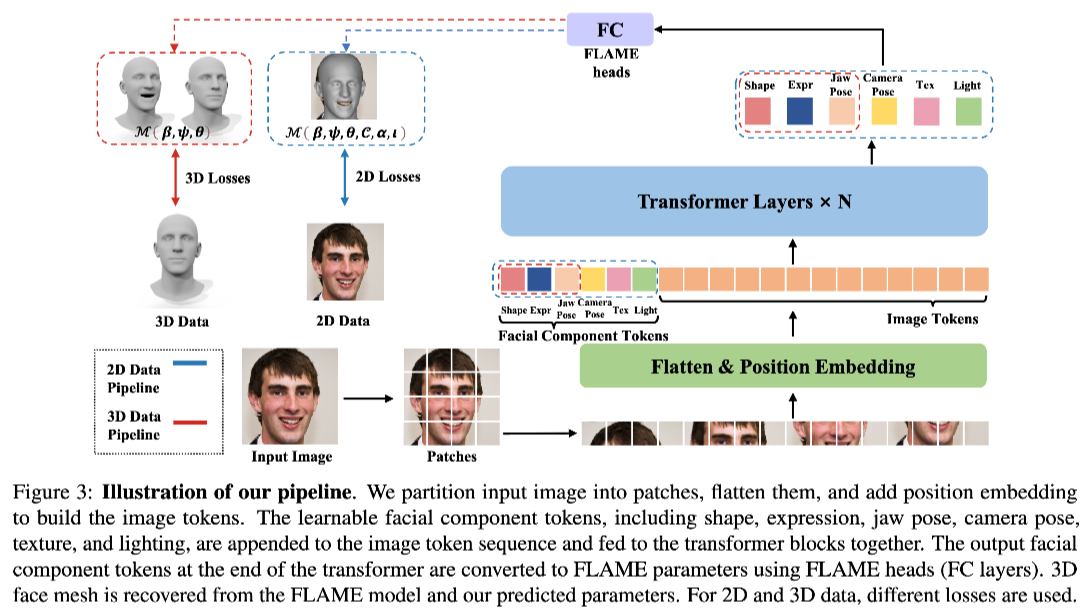

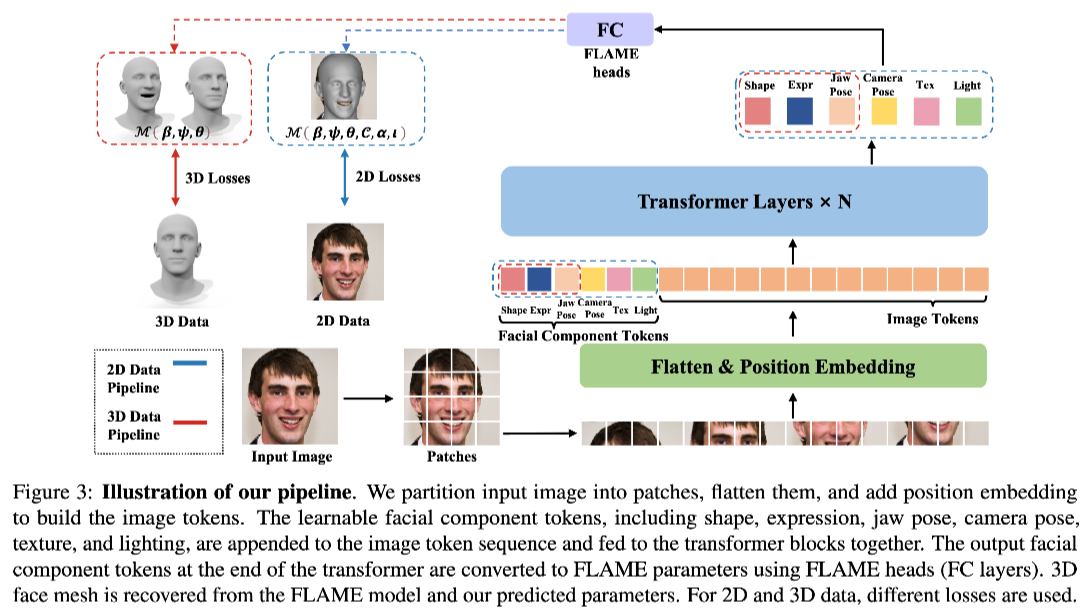

一个基于 Transformer 的高精度单目 3D 人脸重建模型。

摘要:精确地从单目图像和视频中重建 3D 人脸对于各种应用至关重要,例如数字化角色创建等。然而,目前基于深度学习的方法在实现准确重建的过程中,确保解耦面部参数和视频数据处理的稳定性方面面临着重大挑战。在本文中,我们提出了一种基于 Transformer 的单目 3D 人脸重建模型 TokenFace。TokenFace 使用不同面部元素的独立 Token 来捕捉不同面部参数的信息,并采用时间 Transformer 从视频数据中捕捉时间信息。这种设计可以自然地解开不同的面部元素,并对 2D 和 3D 训练数据都兼具灵活性。在混合 2D 和 3D 数据上训练后,该模型能够在图像上准确重建人脸并对视频数据达到稳定重建的能力。在基准数据集 NoW 和 Stirling 上进行的实验结果表明,TokenFace 在所有指标上达到了最先进的性能,大幅优于同期其他方法。

(论文链接待公开)

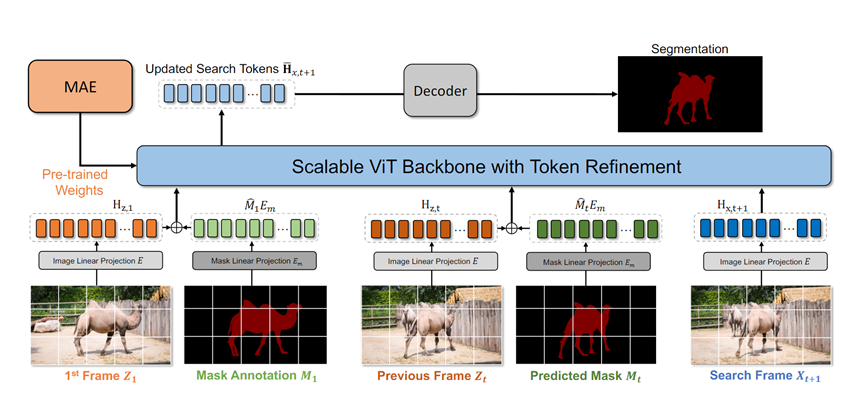

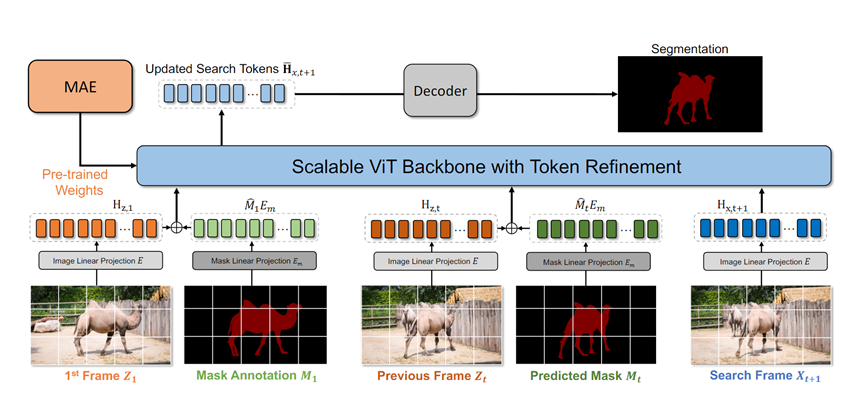

首个纯 ViT 架构的视频分割方法,可借助自监督预训练的 ViT(如 MAE)大幅提升性能。

摘要:当前流行的视频对象分割(VOS)方法通过多个手工设计的模块实现特征匹配,这些模块分别执行特征提取和匹配。然而,上述手工设计的方法在经验上导致目标交互不足,从而限制了 VOS 中动态目标感知特征学习的发展。为了解决这些限制,本文提出了一个简化的 VOS(SimVOS)框架,通过利用单个 Transformer 骨干网络来执行联合特征提取和匹配。这种设计使 SimVOS 能够学习更好的针对目标的特征,从而实现准确的 mask 预测。更重要的是,SimVOS 可以直接使用预训练的 ViT 骨干网络(如 MAE)进行视频分割,从而弥合了 VOS 和大规模自监督预训练之间的差距。为了在性能和速度之间取得更好的平衡,我们进一步探索了帧内注意力,并提出了一种新的 token 细调模块来提高运行速度和节省计算成本。在不使用任何合成视频和 BL30K 预训练数据的情况下,我们取得了 DAVIS-2017(88.0% J&F),DAVIS-2016(92.9% J&F)和 YouTube-VOS 2019(84.2% J&F)的 SOTA 结果。

(论文链接待公开)

近日,ICCV 2023 正式公布论文收录结果,IDEA 研究院 12 篇论文入选,在开放词表目标检测与分割、交互式关键点标注、可控文生图、3D 目标检测、3D 重建、肖像视频生成等领域取得新成果。

ICCV(国际计算机视觉大会,International Conference on Computer Vision)是计算机视觉领域的顶级会议之一,每两年召开一次。根据 Google Scholar Metrics 2022 年榜单,ICCV 在所有计算机科学领域的刊物和会议中位居第 4。ICCV 2023 将于 10 月 2 日至 10 月 6 日法国巴黎举办。

跟随本期文章了解 IDEA 研究院 CV 领域的部分学术成果,欢迎感兴趣的读者阅读论文原文。

简单有效的开放词表分割框架,未见之物亦可分割,是已知的第一个同时训练全景分割和目标检测提升开集分割性能的模型。

摘要:本文提出了一个开放词表图像分割和检测的框架,解决了检测和分割同时训练过程中的 data gap 和 training gap,实现了两大任务在开放词表内的联合训练,并大大提升了分割性能。本文在 COCO 全景分割榜单取得 SOTA,并在多个开集分割任务上超越主流方法。

论文链接:

https://arxiv.org/pdf/2303.08131.pdf

代码链接:

https://github.com/IDEA-Research/OpenSeeD

一个改进新物体标题生成任务多模态表示能力的全新方法。

摘要:本文提出了一种新型的新物体图像标题生成方法,该方法采用相对对比学习来学习视觉和语义对齐,以最大化区域与物体标签的兼容性。为了设置合适的对比学习目标,对于每一张图片,我们使用 CLIP 来扩增标签,并利用每个扩增标签的排序位置作为相对的相关性标签,将每个排名最高的标签与一组排名较低的标签进行对比。这个学习目标鼓励排名最高的标签与其图片和文本上下文的兼容性超过排名较低的标签,从而提高了学习的多模态表示的辨别能力。我们在两个数据集上评估了我们的方法,RCA-NOC 大幅度超越了目前最好的方法,展示出其在改进新物体标题生成任务上的视觉-语言表示的有效性。

(论文链接待公开)

首次定义交互式关键点检测任务,基准框架方法标注效率超越纯手工 10+倍。

摘要:本文首次定义了交互式关键点检测的任务,旨在追求高精度和低成本的标注,并提出了解决该任务的基准框架 Click-Pose,在训练中引入姿态误差建模和交互式人类反馈循环。本方案可以稳定提升标注效率和质量,我们在不同的标注场景中广泛验证了 Click-Pose 的交互式标注有效性,相对手工标注效率提升 10 倍以上,相对 SOTA 模型结合人工修改可提升 5 倍左右,且实现了端到端关键点检测的最先进性能。

(论文链接待公开)

比 ControlNet 更可控更高效的人体图像生成模型 HumanSD。

摘要:本文提出了一个可控人物图像生成方法 HumanSD,旨在高效、准确、原生地控制以人为中心的图片的生成。具体来说,HumanSD 使用一种新颖的热图引导去噪损失(heatmap-guided denoising loss)来微调预训练的 Stable Diffusion 模型,这种策略有效加强了骨骼条件的控制力,同时减轻了灾难性遗忘效应。相比 ControlNet、T2I-Adapter 等即插即用的双分支控制方法,HumanSD 展现了更优的可控力和更快的生成速度,其中可控精度提升 73%。同时,我们提供了适用于人体生成的大规模公开数据集用于后续研究。

论文链接:

https://arxiv.org/abs/2304.04269

代码链接:

https://github.com/IDEA-Research/HumanSD

一个全新基础算子以及基于其实现 2D 特征拉升至 3D 空间的新方法。

摘要:本文提出了一个基础算子:3D Deformable Attention(DFA3D)。基于 DFA3D,我们提出了一种全新的将 2D 特征拉升到 3D 空间的方法。我们与其他的特征拉升方法(Lift-Splat-based、2D Deformable Attention-based 等)进行了公平比较,结果验证了我们 DFA3D-based 的方法的优越性。我们在多个多视角 3D 目标检测方法上进行对比实验,进一步验证了我们的方法的有效性和泛化性。

(论文链接待公开)

通过在损失中仅引入位置度量来改进 DETR 模型匹配稳定性,大幅提升性能。

摘要:本文指出 DETR 中存在的不稳定匹配问题是由多重优化路径所导致,这一问题在 DETR 的 one-to-one matching 中更加明显。论文表明,仅需要在分类损失中引入了位置度量即可很好地优化问题。基于这一原则,我们通过引入了位置度量信息,提出了两个简单有效并且可适用于所有 DETR 系列模型的 position-supervised loss 和 position-modulated matching cost 设计。

我们基于 DETR 系列模型对方法的有效性进行了验证,其中,Stable-DINO 在以 ResNet-50 作为 backbone 的条件下,在 1x 和 2x 标准 settings 下分别达到了 50.4AP 和 51.5AP。本文方法具有强大的可拓展性,使用 Swin-Large 和 Focal-Huge backbone 的条件下,Stable-DINO 在 COCO test-dev 上分别达到了 63.8AP 和 64.8AP 的准确率。

论文链接:

https://arxiv.org/abs/2304.04742

代码链接:

https://github.com/IDEA-Research/Stable-DINO

一个基于编码器、从单图进行 3D 重建的高效方法。

摘要:3D GAN Inversion 旨在从单个图像输入中同时实现高重建保真度和合理的 3D 几何。然而,现有的 3D GAN Inversion 方法依赖于耗时的优化过程,并且是每张图片单独优化。在这项工作中,我们介绍了一种基于 EG3D 的新型基于编码器的 Inversion 框架,EG3D 是最广泛使用的 3D GAN 模型之一。我们利用 EG3D 隐空间的固有属性,设计了一个鉴别器和背景深度正则化,训练出一个具备几何感知能力的编码器,能够将输入图像转换为相应的隐空间向量。此外,我们探索了 EG3D 的特征空间,并开发了一个自适应细化阶段,以提高 EG3D 中特征的表示能力,从而增强细粒度纹理细节的恢复。最后,我们提出了一种考虑遮挡的融合操作,以防止未观察区域的畸变。我们的方法结果可与基于优化的方法媲美,同时运行速度提高了 500 倍。我们的框架非常适用于语义编辑等应用。

论文链接:

https://arxiv.org/pdf/2303.12326.pdf

代码链接:

从蒸馏到自蒸馏:通用归一化损失与定制化软标签。

摘要:知识蒸馏(KD)使用教师的预测 logits 作为软标签来指导学生,而自知蒸馏则不需要真实的教师来提供软标签。本研究通过将通用的 KD 损失分解和重新组织,将这两个任务的公式统一为标准化 KD(NKD)损失和针对目标类别(图像的类别)和非目标类别的定制软标签,命名为通用自知蒸馏(USKD)。我们将 KD 损失分解,并发现其中的非目标损失强制使学生的非目标 logits 与教师的相匹配,但两个非目标 logits 的总和不同,防止它们完全相同。NKD 将非目标 logits 进行归一化,使它们的总和相等。它可以广泛应用于 KD 和自知蒸馏,以更好地利用软标签进行蒸馏损失。USKD 为目标和非目标类别生成定制的软标签,而无需教师。它将学生的目标 logit 平滑处理为软目标标签,并利用中间特征的排名按照 Zipf 定律生成软非目标标签。对于带有教师的 KD,我们的 NKD 在 CIFAR-100 和 ImageNet 数据集上实现了最先进的性能,使用 ResNet-34 教师将 ResNet18 的 ImageNet Top-1 准确率从 69.90%提升到 71.96%。对于没有教师的自知蒸馏,USKD 是第一个可以有效应用于 CNN 和 ViT 模型的自知蒸馏方法,额外的时间和内存开销可以忽略不计,从而获得了新的最先进结果,例如在 ImageNet 上,MobileNet 和 DeiT-Tiny 分别获得了 1.17%和 0.55%的准确率提升。 论文链接:

论文链接:

https://arxiv.org/pdf/2303.13005.pdf

代码链接:

https://github.com/yzd-v/cls_KD

一个从音频驱动指定人物生成高保真且多样的肖像视频的框架。

摘要:音频驱动的肖像视频生成旨在通过给定的音频驱动指定肖像的视频。驱动保真度和多模态的肖像视频肖像具有广泛应用。以往的方法尝试通过训练不同模型或从给定视频中提取信号来捕捉不同的运动模式,以此生成高保真度的肖像视频。然而,缺乏音-唇同步与其他动作(例如头部姿势/眼睛眨动)之间的相关度学习通常导致不自然的驱动结果。在本文中,我们提出了一个统一的系统,用于多人、多模态和高保真度的说话肖像视频生成。该方法包含三个阶段:1)带有双重注意力的网络(MODA)从给定音频中生成说话相关的表征。在 MODA 中,我们设计了一个双重注意力模块,以编码准确的口部动作和多样的模态信息。2)面部合成网络生成密集且详细的面部关键点。3)时序引导的渲染器合成稳定的视频。广泛的评估结果表明,所提出的系统比同期其他方法生成的视频肖像更加自然和逼真。

项目链接:

https://liuyunfei.net/projects/iccv23-moda

代码链接:

https://github.com/DreamtaleCore/MODA

一个基于 Transformer 的高精度单目 3D 人脸重建模型。

摘要:精确地从单目图像和视频中重建 3D 人脸对于各种应用至关重要,例如数字化角色创建等。然而,目前基于深度学习的方法在实现准确重建的过程中,确保解耦面部参数和视频数据处理的稳定性方面面临着重大挑战。在本文中,我们提出了一种基于 Transformer 的单目 3D 人脸重建模型 TokenFace。TokenFace 使用不同面部元素的独立 Token 来捕捉不同面部参数的信息,并采用时间 Transformer 从视频数据中捕捉时间信息。这种设计可以自然地解开不同的面部元素,并对 2D 和 3D 训练数据都兼具灵活性。在混合 2D 和 3D 数据上训练后,该模型能够在图像上准确重建人脸并对视频数据达到稳定重建的能力。在基准数据集 NoW 和 Stirling 上进行的实验结果表明,TokenFace 在所有指标上达到了最先进的性能,大幅优于同期其他方法。

(论文链接待公开)

首个纯 ViT 架构的视频分割方法,可借助自监督预训练的 ViT(如 MAE)大幅提升性能。

摘要:当前流行的视频对象分割(VOS)方法通过多个手工设计的模块实现特征匹配,这些模块分别执行特征提取和匹配。然而,上述手工设计的方法在经验上导致目标交互不足,从而限制了 VOS 中动态目标感知特征学习的发展。为了解决这些限制,本文提出了一个简化的 VOS(SimVOS)框架,通过利用单个 Transformer 骨干网络来执行联合特征提取和匹配。这种设计使 SimVOS 能够学习更好的针对目标的特征,从而实现准确的 mask 预测。更重要的是,SimVOS 可以直接使用预训练的 ViT 骨干网络(如 MAE)进行视频分割,从而弥合了 VOS 和大规模自监督预训练之间的差距。为了在性能和速度之间取得更好的平衡,我们进一步探索了帧内注意力,并提出了一种新的 token 细调模块来提高运行速度和节省计算成本。在不使用任何合成视频和 BL30K 预训练数据的情况下,我们取得了 DAVIS-2017(88.0% J&F),DAVIS-2016(92.9% J&F)和 YouTube-VOS 2019(84.2% J&F)的 SOTA 结果。

(论文链接待公开)