自 1956 年的达特茅斯会议开启“人工智能元年”,该领域经过了两起两落。到 2006 年前后,虽然 Hinton 等人已发表论文证明,通过增加神经网络的层数,可以学到更好的数据表征,并进一步提升模型的性能,但是大家认为这还是新瓶换旧酒,还在迟疑中。直到深度学习概念的推广,在语言识别等领域获得成功。特别是 2012 年 AlexNet 在 ImageNet 的比赛中取得重大突破,性能提升 10 多个百分点。深度神经网络的实际效果进一步得到肯定,并掀起了人工智能的第三波热潮。CV“四小龙”亦在此时间段前后成立,开启感知智能的创业浪潮。

ResNet 和 AlphaGo 等成果的推出,进一步完善神经网络的训练并拓展了其应用范围,从而将这波浪潮推到新高度。2018 年秋季谷歌推出 BERT,横扫了 11 项自然语言处理(NLP)任务,随后 OpenAI 亦相继推出 GPT-2、GPT-3,让大家看到认知智能落地的潜在性。

时光如梭,2021 年悄然过去。蓦然回首,2021 年的 AI 大事件有哪些呢?新的一年,AI 又将呈现怎样的发展趋势?我们将按下述几个主题展开:

从业界的角度看,2021 年的一个关键词是“大模型”。

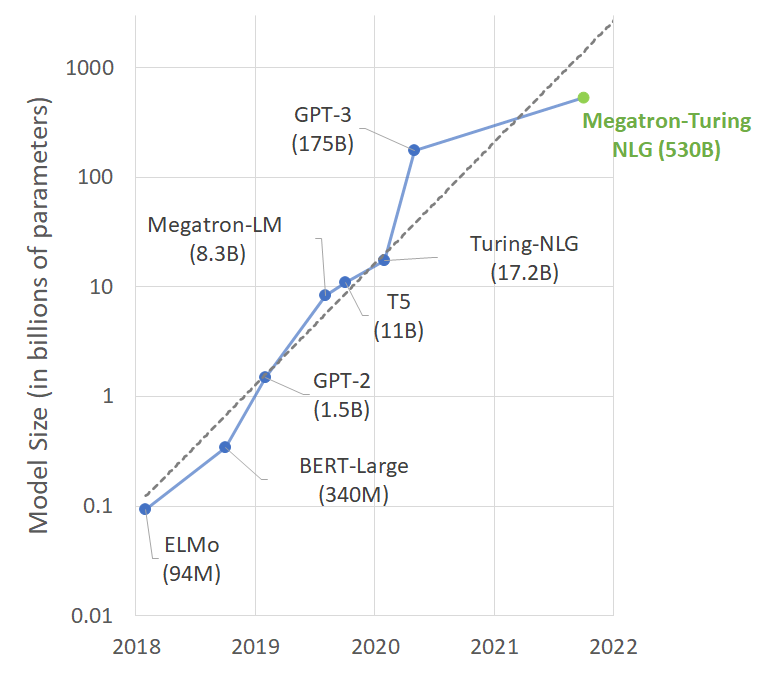

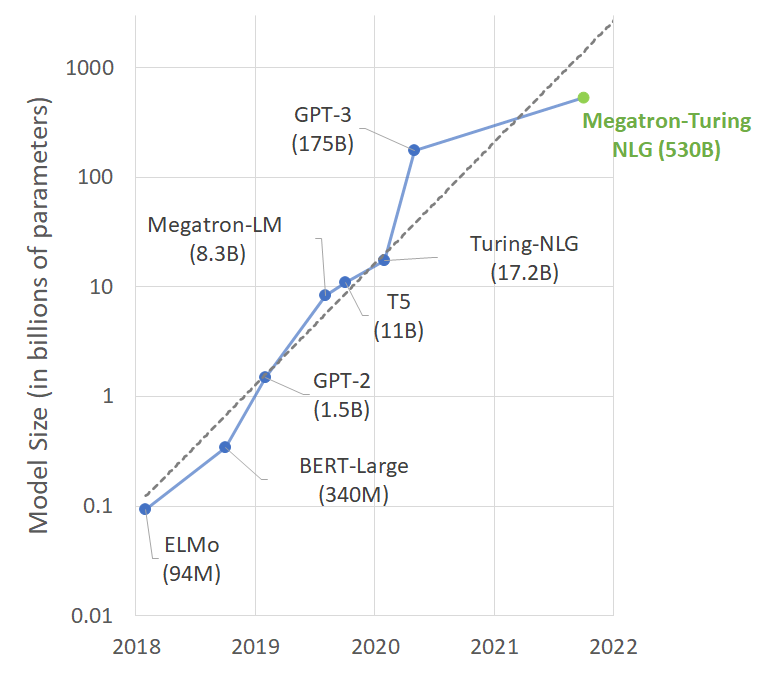

如图 1 所示,当 GPT-3 的模型规模达到 1750 亿参数后,国外大厂又提出了各样的模型,进一步提高了模型的大小。具有代表性的成果有:

图 1. NLP 预训练模型参数随着时间发展的趋势(图片源自[2])

图 1. NLP 预训练模型参数随着时间发展的趋势(图片源自[2])国内在今年亦推出了万亿级的预训练模型和开源计划。例如:

目前,预训练大模型已成为各家打造人工智能基础设施的利器,从而提高行业的准入壁垒。实现大模型,需要超大规模的算力和海量的数据。这对普通公司或者一般实验室会造成一定的困难。然而就技术而言,目前的大模型离我们期望的通用人工智能还有很大的差距。如何让电脑有更多的创意,知识不断地积累,还需要进行大量的技术探索和创新。在落地的时候还需要更多地跟场景结合,甚至需要场景创新,才能更好地服务相关行业。

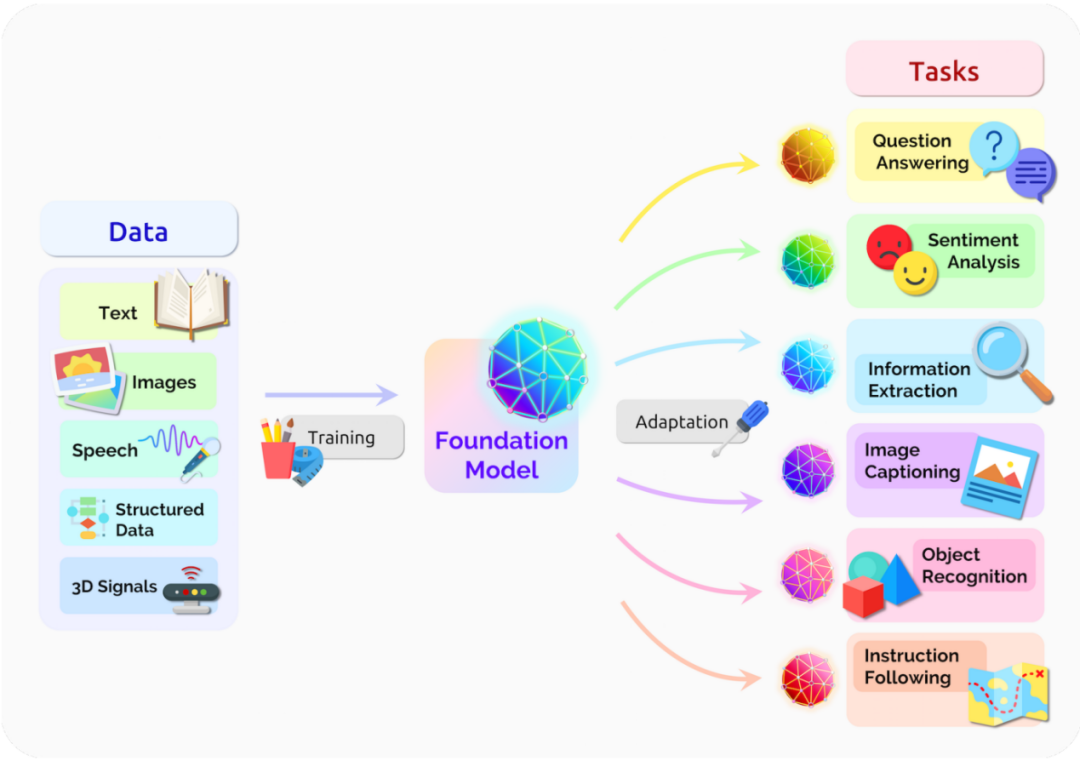

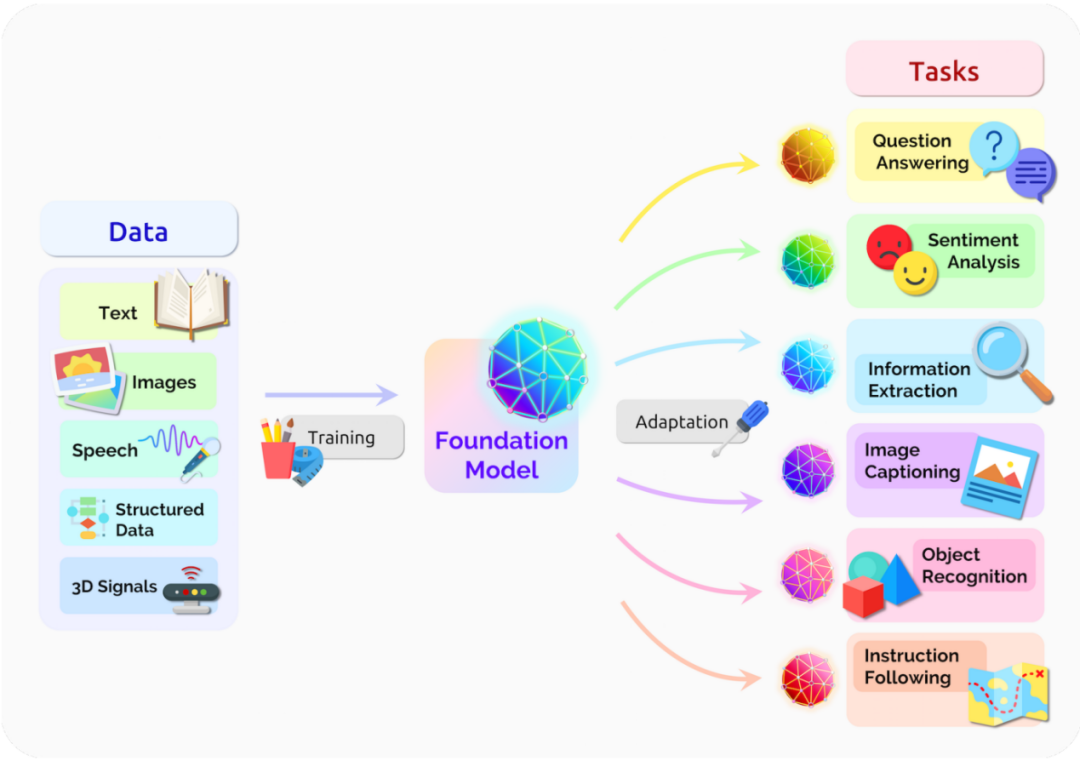

大模型的不断推出,基本上基于深度神经网络和自学习的方式进行,各个模型趋于“同质化”(Homogenization)。因此,斯坦福大学的 Percy Liang 于 2021 年 3 月份召集了 100 多位研究学者,发起了基石模型(Foundation Models)的讨论,并于 8 月发表了一篇 200 多页的关于基石模型的综述报告[5]。

该报告定义了基石模型,试图囊括目前大模型的能力、应用、相关技术和社会影响。主要从语言、视觉、机器人、推理、交互、理解等讨论基石模型的能力,在应用方面主要探讨医疗、法律和教育这三个对社会很重要的学科。

与此同时,在构建基石模型方面,亦出现了几个有影响力的工作,拓展了应用的边界。例如:

在学术界,对比学习、多模态多任务联合学习,已经广泛使用于基石模型的训练中。但是模型的解释性和拓展性还有很多的探索空间。

尽管目前 AI 技术在刷脸支付、自动驾驶、智能语音、智能安防等应用的商业化探索和落地,已开始改变我们的生活模式,并带来巨大的便利,AI 技术仍要面对更多、更复杂的场景。2021 年是 AI 技术迫切需要落地的一年。在落地的过程中,我们经常需要面对如下问题:

而从 AI 技术层面看,AI 落地的三要素是: 算力、算法和数据。这就涉及到公平性和伦理的问题。特别是,最近几年数据的隐私安全、AI 算法的责任,都成为社会的关注热点。在今年我国亦出台相关法律从不同层面保障用户的隐私和利益,包括

AI 技术在落地的过程,要兼具安全和确定相关的责任方,同时还要顾及公平和伦理。随着众多新的法案的出台,后续的落地会受到更多的监管和共同治理,走向“科技向善、AI 向善”的道路。

目前人工智能技术距离理想的通用人工智能的路还很长,2021 年有更多的大厂试图构建相应的基石模型,并把 AI 技术拓展到更大的应用范围。

在技术层面,还需要大量的探索,例如,是否有更好的架构替代基于深度神经网络的架构?是否有更快的方式提升计算性能?大模型如何在实际场景很好地落地?相关的技术,如 Neurosymbolic AI、量子计算都很值得研究。

在应用层面,AI 跟科学发现、AI 制药、AI 跟大数据应用结合等等,都有很多的机会。如何将算法与场景结合、技术与产业融合,是未来实现 AI 落地应用必须思考的问题。国内已有一些机构或团队正在探索研产结合的可能路径,例如 IDEA 的 CTO Labs 合作计划,聚集科研人才和产业科技团队,共同挖掘产业痛点,更有效推进核心技术研发和落地。最近亦与数说故事合作,在数说的产品中提供关键技术模块。

关于作者:

杨海钦现任 IDEA 的主任研究员和数说故事实验室负责人。博士毕业于香港中文大学。曾任教于香港恒生管理学院,香港中文大学客座副教授,后就职于美图(中国)、平安寿险,负责自然语言处理的研究和落地。他在机器学习、自然语言处理等领域已发表论文 60 余篇。获得亚太神经网络学会 2018 年“年青科学家奖”,并入选 2009-2019 年 AI2000 经典 AI(AAAI/IJCAI)全球最具影响力学者榜单。他亦担任过 ICONIP’20 程序委员会主席,AI 顶会等的资深程序委员会成员或领域主席。”

参考文献:

[1] William Fedus, Barret Zoph, Noam Shazeer: Switch Transformers: Scaling to Trillion Parameter Models with Simple and Efficient Sparsity. CoRR abs/2101.03961 (2021).

[2] Paresh Kharya and Ali Alvi. Using DeepSpeed and Megatron to Train Megatron-Turing NLG 530B, the World’s Largest and Most Powerful Generative Language Model.

[3] 全球最大智能模型“悟道 2.0”重磅发布. https://hub.baai.ac.cn/view/8375.

[4] 2021 IDEA 大会重磅宣布,“封神榜”大模型开源计划开启——“封神榜”大模型系列宣告开源,有多“神”?https://www.idea.edu.cn/news/20211124222723.html.

[5] Rishi Bommasani, Drew A. Hudson, Ehsan Adeli, et al.: On the Opportunities and Risks of Foundation Models. CoRR abs/2108.07258 (2021).

[6] Gershgorn, Dave. GitHub and OpenAI launch a new AI tool that generates its own code. The Verge. 29 June 2021 [6 July 2021].

[7] Amanpreet Singh, Ronghang Hu, Vedanuj Goswami, Guillaume Couairon, Wojciech Galuba, Marcus Rohrbach, Douwe Kiela: FLAVA: A Foundational Language And Vision Alignment Model. CoRR abs/2112.04482 (2021).

[8] Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, Neil Houlsby: An Image is Worth 16×16 Words: Transformers for Image Recognition at Scale. ICLR 2021.

[9] IDEA 合作企业数说故事产品上新 携手推动商业应用智能化.

https://zhuanlan.zhihu.com/p/458813386. 2022-01-18.

自 1956 年的达特茅斯会议开启“人工智能元年”,该领域经过了两起两落。到 2006 年前后,虽然 Hinton 等人已发表论文证明,通过增加神经网络的层数,可以学到更好的数据表征,并进一步提升模型的性能,但是大家认为这还是新瓶换旧酒,还在迟疑中。直到深度学习概念的推广,在语言识别等领域获得成功。特别是 2012 年 AlexNet 在 ImageNet 的比赛中取得重大突破,性能提升 10 多个百分点。深度神经网络的实际效果进一步得到肯定,并掀起了人工智能的第三波热潮。CV“四小龙”亦在此时间段前后成立,开启感知智能的创业浪潮。

ResNet 和 AlphaGo 等成果的推出,进一步完善神经网络的训练并拓展了其应用范围,从而将这波浪潮推到新高度。2018 年秋季谷歌推出 BERT,横扫了 11 项自然语言处理(NLP)任务,随后 OpenAI 亦相继推出 GPT-2、GPT-3,让大家看到认知智能落地的潜在性。

时光如梭,2021 年悄然过去。蓦然回首,2021 年的 AI 大事件有哪些呢?新的一年,AI 又将呈现怎样的发展趋势?我们将按下述几个主题展开:

从业界的角度看,2021 年的一个关键词是“大模型”。

如图 1 所示,当 GPT-3 的模型规模达到 1750 亿参数后,国外大厂又提出了各样的模型,进一步提高了模型的大小。具有代表性的成果有:

图 1. NLP 预训练模型参数随着时间发展的趋势(图片源自[2])

图 1. NLP 预训练模型参数随着时间发展的趋势(图片源自[2])国内在今年亦推出了万亿级的预训练模型和开源计划。例如:

目前,预训练大模型已成为各家打造人工智能基础设施的利器,从而提高行业的准入壁垒。实现大模型,需要超大规模的算力和海量的数据。这对普通公司或者一般实验室会造成一定的困难。然而就技术而言,目前的大模型离我们期望的通用人工智能还有很大的差距。如何让电脑有更多的创意,知识不断地积累,还需要进行大量的技术探索和创新。在落地的时候还需要更多地跟场景结合,甚至需要场景创新,才能更好地服务相关行业。

大模型的不断推出,基本上基于深度神经网络和自学习的方式进行,各个模型趋于“同质化”(Homogenization)。因此,斯坦福大学的 Percy Liang 于 2021 年 3 月份召集了 100 多位研究学者,发起了基石模型(Foundation Models)的讨论,并于 8 月发表了一篇 200 多页的关于基石模型的综述报告[5]。

该报告定义了基石模型,试图囊括目前大模型的能力、应用、相关技术和社会影响。主要从语言、视觉、机器人、推理、交互、理解等讨论基石模型的能力,在应用方面主要探讨医疗、法律和教育这三个对社会很重要的学科。

与此同时,在构建基石模型方面,亦出现了几个有影响力的工作,拓展了应用的边界。例如:

在学术界,对比学习、多模态多任务联合学习,已经广泛使用于基石模型的训练中。但是模型的解释性和拓展性还有很多的探索空间。

尽管目前 AI 技术在刷脸支付、自动驾驶、智能语音、智能安防等应用的商业化探索和落地,已开始改变我们的生活模式,并带来巨大的便利,AI 技术仍要面对更多、更复杂的场景。2021 年是 AI 技术迫切需要落地的一年。在落地的过程中,我们经常需要面对如下问题:

而从 AI 技术层面看,AI 落地的三要素是: 算力、算法和数据。这就涉及到公平性和伦理的问题。特别是,最近几年数据的隐私安全、AI 算法的责任,都成为社会的关注热点。在今年我国亦出台相关法律从不同层面保障用户的隐私和利益,包括

AI 技术在落地的过程,要兼具安全和确定相关的责任方,同时还要顾及公平和伦理。随着众多新的法案的出台,后续的落地会受到更多的监管和共同治理,走向“科技向善、AI 向善”的道路。

目前人工智能技术距离理想的通用人工智能的路还很长,2021 年有更多的大厂试图构建相应的基石模型,并把 AI 技术拓展到更大的应用范围。

在技术层面,还需要大量的探索,例如,是否有更好的架构替代基于深度神经网络的架构?是否有更快的方式提升计算性能?大模型如何在实际场景很好地落地?相关的技术,如 Neurosymbolic AI、量子计算都很值得研究。

在应用层面,AI 跟科学发现、AI 制药、AI 跟大数据应用结合等等,都有很多的机会。如何将算法与场景结合、技术与产业融合,是未来实现 AI 落地应用必须思考的问题。国内已有一些机构或团队正在探索研产结合的可能路径,例如 IDEA 的 CTO Labs 合作计划,聚集科研人才和产业科技团队,共同挖掘产业痛点,更有效推进核心技术研发和落地。最近亦与数说故事合作,在数说的产品中提供关键技术模块。

关于作者:

杨海钦现任 IDEA 的主任研究员和数说故事实验室负责人。博士毕业于香港中文大学。曾任教于香港恒生管理学院,香港中文大学客座副教授,后就职于美图(中国)、平安寿险,负责自然语言处理的研究和落地。他在机器学习、自然语言处理等领域已发表论文 60 余篇。获得亚太神经网络学会 2018 年“年青科学家奖”,并入选 2009-2019 年 AI2000 经典 AI(AAAI/IJCAI)全球最具影响力学者榜单。他亦担任过 ICONIP’20 程序委员会主席,AI 顶会等的资深程序委员会成员或领域主席。”

参考文献:

[1] William Fedus, Barret Zoph, Noam Shazeer: Switch Transformers: Scaling to Trillion Parameter Models with Simple and Efficient Sparsity. CoRR abs/2101.03961 (2021).

[2] Paresh Kharya and Ali Alvi. Using DeepSpeed and Megatron to Train Megatron-Turing NLG 530B, the World’s Largest and Most Powerful Generative Language Model.

[3] 全球最大智能模型“悟道 2.0”重磅发布. https://hub.baai.ac.cn/view/8375.

[4] 2021 IDEA 大会重磅宣布,“封神榜”大模型开源计划开启——“封神榜”大模型系列宣告开源,有多“神”?https://www.idea.edu.cn/news/20211124222723.html.

[5] Rishi Bommasani, Drew A. Hudson, Ehsan Adeli, et al.: On the Opportunities and Risks of Foundation Models. CoRR abs/2108.07258 (2021).

[6] Gershgorn, Dave. GitHub and OpenAI launch a new AI tool that generates its own code. The Verge. 29 June 2021 [6 July 2021].

[7] Amanpreet Singh, Ronghang Hu, Vedanuj Goswami, Guillaume Couairon, Wojciech Galuba, Marcus Rohrbach, Douwe Kiela: FLAVA: A Foundational Language And Vision Alignment Model. CoRR abs/2112.04482 (2021).

[8] Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit, Neil Houlsby: An Image is Worth 16×16 Words: Transformers for Image Recognition at Scale. ICLR 2021.

[9] IDEA 合作企业数说故事产品上新 携手推动商业应用智能化.

https://zhuanlan.zhihu.com/p/458813386. 2022-01-18.