近日,在 IDEA 研究院主任研究员、IDEA 数说故事实验室(IDEA DataStory AI Lab)负责人杨海钦博士的提议和指导下,由来自悉尼大学的两位实习生龙思曲和曹斐祺主要撰写完成的论文“Vision-and-Language Pretrained Models: A Survey”获得 IJCAI-ECAI 2022 Survey Track 收录。今年 IJCAI-ECAI Survey Track 共有 209 篇投稿进入评审阶段,其中 38 篇文章被收录,录用率仅为 18%。

IDEA 数说故事实验室借助合作企业数说故事千亿级基础数据平台,提供核心算法,帮助客户实现数字化转型,目前专注于开放域商业事理图谱构建、多模态技术和开放性知识图谱构建。今年初,实验室在杨海钦博士的带领下,充分理解业务需求,研发上线了拥有核心知识产权的事件抽取模块(IDEA 合作企业数说故事产品上新 携手推动商业应用智能化)。

此篇论文是对多模态技术的一次探索,后续将在数说的更多场景中落地,拓展 AI 应用的边界。(推荐拓展阅读:从 1750 亿到 1.6 万亿,人工智能未来:除了大模型,还有什么?)

论文摘要

预训练模型在计算机视觉(CV)和自然语言处理(NLP)领域已取得巨大成功,随之带动了图文预训练模型(Visual-Language Pretrained Models, VLPMs)的发展。论文综述了图文预训练模型的主要进展,包括主要的模型架构、图文数据的编码方式、基础的预训练和微调技术、图文理解中的主要下游任务,以及未来的主要研究方向。

论文地址:

https://arxiv.org/abs/2204.07356

ReadPaper 地址:

https://readpaper.com/paper/675963230332678144

* 推荐通过 ReadPaper 阅读本文,可一键收藏及浏览参考文献、划线翻译、在线笔记等。点击文末“阅读原文”即可直达。

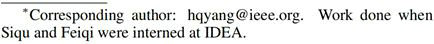

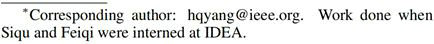

论文开头着重介绍了图文预训练模型的通用架构(参见图 1),即图文原始数据输入(V/L Raw Input Data)、图文表征 (V/L Representation)、图文交互模型 (V-L (Vision-Language) Interaction Model)和图文联合表征 (V-L Representation)。此通用架构适用于大多数现有的图文预训练模型。每个组件、预训练的策略和迁移应用的设计都可以不同。

随后,论文概述了文字数据编码(Language Encoding)和图像数据编码(Vision Encoding)两种不同的图像数据输入方式。文章在回顾现有模型针对图像嵌入方法的创新之余,详细对比了模型在不同细粒度上的嵌入方法,并概括了模型在文字及图像数字编码过程中增强单模态表示的思路、方法和结论。

接着,作者从全新角度,总结出现有的三类图文交互方式模型(V-L interaction models):基于自注意力机制(Self-attention-based)、基于协同注意力机制(Co-attention-based)和基于视觉语义嵌入(Visual-Semantic-Embedding(VSE)-based)的对比学习模型。论文还详尽展示了本领域的预训练数据集,并模块化地总结了各种重要的预训练任务。

之后,论文把视角延伸到两类图文预训练模型的下游任务,即图文理解任务(V-L Understanding)和图文生成任务(V-L Generation),详尽回顾了现有方法在各项下游任务中的验证方式:

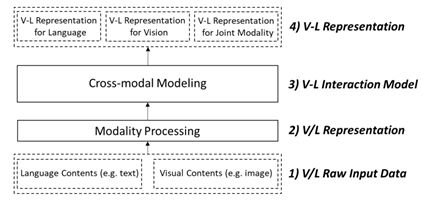

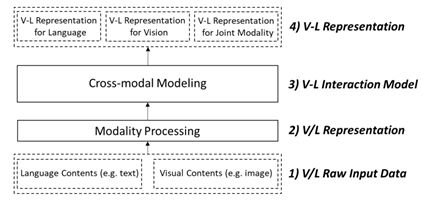

● 图文理解任务(V-L Understanding):介绍了视觉问答(Visual Question Answering)、跨模态检索(Cross Modal Retrieval)、文本分类(Text Classification)等图文理解任务,并对现有方法在下游任务上的应用情况进行了回顾(参见表 1)。

● 图文生成任务(V-L Generation):介绍了基于多模态或单模态的下游生成式任务,如看图说话(Image Captioning)任务、多模态机器翻译(Multi-modal Machine Translation)任务等。

为推进此领域发展,文章最后提出了三个具有前景的研究方向:

● 图文交互建模:研究如何准确地对齐图像和文本之间在不同细粒度层级上的特征,依旧是一个值得探索的问题。

● 图文预训练策略:对图文预训练策略的探索,也许可以为视觉语言预训练模型的未来发展提供有价值的指南。

● 训练评估:找到针对预训练模型的直接评估方法,改善现有训练模型仅依赖下游任务表现,而可能造成的资源计算的浪费。

IDEA 数说故事实验室

主任研究员

杨海钦 博士

杨海钦现任 IDEA 研究院主任研究员和 IDEA 数说故事实验室负责人,博士毕业于香港中文大学。杨博士曾任教于香港恒生管理学院,亦曾担任香港中文大学客座副教授,曾就职于美图(中国)、平安寿险,负责自然语言处理的研究和落地。他在机器学习、自然语言处理等领域已发表论文 60 余篇,获得亚太神经网络学会 2018 年“年青科学家奖”,并多次入选 AI2000 经典 AI(AAAI/IJCAI)全球最具影响力学者榜单。他曾担任 ICONIP’20 程序委员会主席、AAAI/IJCAI 等机器学习顶议的领域主席。

近日,在 IDEA 研究院主任研究员、IDEA 数说故事实验室(IDEA DataStory AI Lab)负责人杨海钦博士的提议和指导下,由来自悉尼大学的两位实习生龙思曲和曹斐祺主要撰写完成的论文“Vision-and-Language Pretrained Models: A Survey”获得 IJCAI-ECAI 2022 Survey Track 收录。今年 IJCAI-ECAI Survey Track 共有 209 篇投稿进入评审阶段,其中 38 篇文章被收录,录用率仅为 18%。

IDEA 数说故事实验室借助合作企业数说故事千亿级基础数据平台,提供核心算法,帮助客户实现数字化转型,目前专注于开放域商业事理图谱构建、多模态技术和开放性知识图谱构建。今年初,实验室在杨海钦博士的带领下,充分理解业务需求,研发上线了拥有核心知识产权的事件抽取模块(IDEA 合作企业数说故事产品上新 携手推动商业应用智能化)。

此篇论文是对多模态技术的一次探索,后续将在数说的更多场景中落地,拓展 AI 应用的边界。(推荐拓展阅读:从 1750 亿到 1.6 万亿,人工智能未来:除了大模型,还有什么?)

论文摘要

预训练模型在计算机视觉(CV)和自然语言处理(NLP)领域已取得巨大成功,随之带动了图文预训练模型(Visual-Language Pretrained Models, VLPMs)的发展。论文综述了图文预训练模型的主要进展,包括主要的模型架构、图文数据的编码方式、基础的预训练和微调技术、图文理解中的主要下游任务,以及未来的主要研究方向。

论文地址:

https://arxiv.org/abs/2204.07356

ReadPaper 地址:

https://readpaper.com/paper/675963230332678144

* 推荐通过 ReadPaper 阅读本文,可一键收藏及浏览参考文献、划线翻译、在线笔记等。点击文末“阅读原文”即可直达。

论文开头着重介绍了图文预训练模型的通用架构(参见图 1),即图文原始数据输入(V/L Raw Input Data)、图文表征 (V/L Representation)、图文交互模型 (V-L (Vision-Language) Interaction Model)和图文联合表征 (V-L Representation)。此通用架构适用于大多数现有的图文预训练模型。每个组件、预训练的策略和迁移应用的设计都可以不同。

随后,论文概述了文字数据编码(Language Encoding)和图像数据编码(Vision Encoding)两种不同的图像数据输入方式。文章在回顾现有模型针对图像嵌入方法的创新之余,详细对比了模型在不同细粒度上的嵌入方法,并概括了模型在文字及图像数字编码过程中增强单模态表示的思路、方法和结论。

接着,作者从全新角度,总结出现有的三类图文交互方式模型(V-L interaction models):基于自注意力机制(Self-attention-based)、基于协同注意力机制(Co-attention-based)和基于视觉语义嵌入(Visual-Semantic-Embedding(VSE)-based)的对比学习模型。论文还详尽展示了本领域的预训练数据集,并模块化地总结了各种重要的预训练任务。

之后,论文把视角延伸到两类图文预训练模型的下游任务,即图文理解任务(V-L Understanding)和图文生成任务(V-L Generation),详尽回顾了现有方法在各项下游任务中的验证方式:

● 图文理解任务(V-L Understanding):介绍了视觉问答(Visual Question Answering)、跨模态检索(Cross Modal Retrieval)、文本分类(Text Classification)等图文理解任务,并对现有方法在下游任务上的应用情况进行了回顾(参见表 1)。

● 图文生成任务(V-L Generation):介绍了基于多模态或单模态的下游生成式任务,如看图说话(Image Captioning)任务、多模态机器翻译(Multi-modal Machine Translation)任务等。

为推进此领域发展,文章最后提出了三个具有前景的研究方向:

● 图文交互建模:研究如何准确地对齐图像和文本之间在不同细粒度层级上的特征,依旧是一个值得探索的问题。

● 图文预训练策略:对图文预训练策略的探索,也许可以为视觉语言预训练模型的未来发展提供有价值的指南。

● 训练评估:找到针对预训练模型的直接评估方法,改善现有训练模型仅依赖下游任务表现,而可能造成的资源计算的浪费。

IDEA 数说故事实验室

主任研究员

杨海钦 博士

杨海钦现任 IDEA 研究院主任研究员和 IDEA 数说故事实验室负责人,博士毕业于香港中文大学。杨博士曾任教于香港恒生管理学院,亦曾担任香港中文大学客座副教授,曾就职于美图(中国)、平安寿险,负责自然语言处理的研究和落地。他在机器学习、自然语言处理等领域已发表论文 60 余篇,获得亚太神经网络学会 2018 年“年青科学家奖”,并多次入选 AI2000 经典 AI(AAAI/IJCAI)全球最具影响力学者榜单。他曾担任 ICONIP’20 程序委员会主席、AAAI/IJCAI 等机器学习顶议的领域主席。